Планирование эксперимента и анализ данных

Опубликовано 09.12.2019 в ChSU

Приветствую всех заинтересованных!

Данный раздел посвящен основам планирования эксперимента и анализу полученных данных. Это является основной любой научной и аналитической работы. При этом я не вижу больших различий в том, какая это будет наука или дисциплина. По сути мы проводим эксперименты и обрабатываем данные постоянно в нашей жизни. Так что постараюсь сделать этот курс максимально полезным и осмысленным вне зависимости от области применения. Ведь все мы в той или иной мере являемся учеными и инженерами и в обычной жизни (вопрос в том: хорошими или плохими?). Мы решаем различные оптимизационные задачи (например, как получать бОльшую зарплату), накапливаем данные через наблюдения и строим выводы, опираясь на собственный опыт.

Целью курса является формирование общих теоретических и практических представлений о том, что такое наука, данные и эксперимент.

Основные задачи:

- Показать терминологию и логику построения экспериментов в науке.

- Описать особенности проведения эксперимента с точки зрения исследуемых факторов.

- Определить эффективные пути проведения эксперимента и получения информации с целью оптимизации отклика системы.

- Дать введение в статистику и обработку результатов.

- Познакомить с построением линейных регрессионных моделей со статистической точки зрения.

- Рассмотреть и решить некоторые примеры и задачи по теме курса.

Многие задачи и определения взяты с прекрасных курсов coursera.org и stepic.org (подробнее в списке литературы), а также из различных учебников и пособий по аналитической химии. Категорически рекомендую вам эти платформы дистанционного обучения.

Весь представленный здесь материал исследован, структурирован и переработан исходя из собственного опыта работы и отражает мой субъективный взгляд на вещи.

0. Оглавление

- Введение. Наука и научный подход

- Эксперимент. Система и факторы

- Введение и терминология

- Анализ двухфакторного эксперимента

- Построение прогнозов

- Взаимодействие между факторами

- Трехфакторный эксперимент

- Построение модели методом наименьших квадратов (МНК) для 2 факторного эксперимента

- Анализ факторного эксперимента с использованием RStudio

- Сокращение затрат на эксперименты

- Построение карты эксперимента

- Заключение

- Вопросы по разделу

- Сравнительные эксперименты. Статистическая практика

- Построение точных моделей. Аналитическая практика

1. Введение. Наука и научный подход

Итак, наука и научный подход — что это такое?

Наука (от лат. scientia — знания) — системное представление о строении и организации знаний (информации) о вселенной с возможностью проверки и предсказания.

Вообще, как известно из древнегреческой философии, для изучения окружающего мира человеку доступно лишь две возможности: наблюдение и эксперимент. Данное утверждение можно принять за аксиому (по крайней мере я не встречал противоречий и в современном мире).

При этом научную деятельность можно охарактеризовать следующим образом - это сбор данных через наблюдения и эксперименты. Их постоянное обновление, систематизация и анализ. Следствием всего этого является получение (синтез) новых знаний и законов нашего мира.

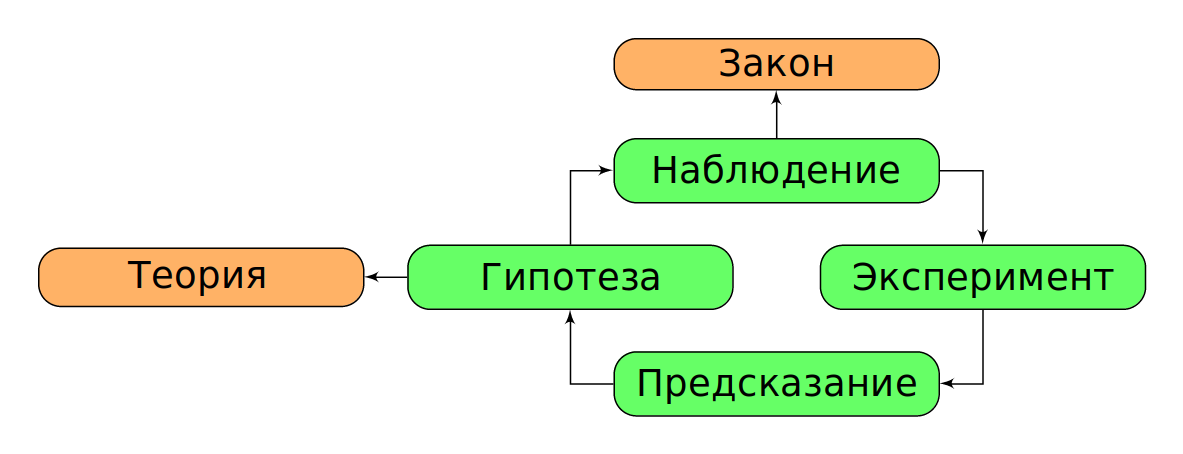

Другими словами: на основе данных, мы создаем теории и гипотезы, которые подтверждаются/опровергаются наблюдениями или экспериментами. Это и есть наука. Таким образом можно предположить следующий цикл научного познания (рис. 1, табл. 1).

|

Рис. 1. Взаимосвязь научных понятий. |

Таблица 1. Термины научного познания

| применимо к единице или малому количеству | применимо ко всем случаем | |

|---|---|---|

| описывает что происходит | наблюдение | закон |

| объясняет почему явление происходит | гипотеза | теория |

Как правило в любой науке мы с вами будем работать над гипотезами и теориями, оперируя законами и наблюдениями (все на основе данных).

При этом не стоит забывать, что основным инструментом описания и классификации любого явления является математика. Для эффективной же работы в современном мире нам требуется еще один инструмент — программирование. Советую не забывать об этом и тогда ваша конкурентоспособность будет высокой.

Сам же эксперимент - это неотрывная частью науки и нашей жизни. Это запланированное наблюдение (проводимое с какой-либо целью). Все мы проводим эксперименты в повседневной жизни. Как сказал один преподаватель, если вы перестали экспериментировать - вы разочаровались в жизни. А это значит, что пора начать любое движение и снова экспериментировать.

Задача. Подумайте, какие эксперименты вы проводили в недавнее время? Что значит эксперимент для вас?

Вот хороший пример эксперимента. Допусти, мы выращиваем растение у себя перед монитором и поставили себе цель - оптимизировать его рост. В первую очередь, стоит проанализировать в чем выражается рост: длинна, количество листьев, вес и т.д.. Затем, нужно определить параметры, которые могут влиять на длину растения: количество воды для полива, частота полива, тип почвы, тип горшка для растения, тип удобрения, количество удобрения, свет, температура и т.д..

Таким образом, мы получили довольно много факторов, для которых нужно провести эксперименты, что бы узнать, какой фактор (или комбинация факторов) позволит нам добиться цели.

Примечание. Предлагаю запомнить последовательность: цель - факторы в которых выражается цель - влияющие на факторы параметры - эксперимент.

Из этого примера мы можем понять, с чем столкнемся дальше. Нам предстоит планировать и описывать эксперименты, а также обрабатывать данные и доказывать их правоту (представительность) с точки зрения статистики.

Для планирования эксперимента важно знать теорию соответствующей ему области знаний (в которой мы проводим этот эксперимент) и терминологию (что бы правильно ставить цели и определять параметры). Помимо этого, важно пользоваться обозначенным ранее научным циклом. А теперь, непосредственно к делу.

2. Эксперимент. Система и факторы

2.1 Введение и терминология

При проведении эксперимента, нашей целью является результат (outcome) - то, что мы хотим узнать/оптимизировать/представить в численном виде (т.е. то, что можно измерить). Синонимами результата являются реакция/оклик системы.

Факторы (factors, features) - изменяемые свойства, от которых предположительно зависит результат эксперимента (на них влияют соответствующие переменные (variables), но часто данные термины используют как синонимы).

Все эксперименты должны иметь хотя бы 1 изменяемый (и измеряемый) фактор. И чем больше факторов мы примем к рассмотрению, тем лучше (в общем случае).

Сами факторы делятся на:

- количественные (quantitative) - которые можно измерить и сравнить (упорядочить по возрастанию/убыванию);

- качественные (категориальные, номинативные, qualitative) - определяющие тип, но которые нельзя сравнить.

Иногда выделяют еще и ранговые факторы - определяющие тип, но которые можно сравнить (например, место в соревновании и т.п.). Но для анализа результатов в подавляющем случае используют только количественные или качественные величины. Ранговые величины используются при расчете различных статистических критериев.

Пример. Давайте рассмотрим классический пример построения эксперимента и обработки его результатов. Мы хотим увеличить прибыль магазина (\(= \text{доход} - \text{расходы}\)) и считаем, что на это будут влиять 2 фактора: освещенность помещения (можем выставить диммер освещения на 50% и 75%) и цена товара (допустим 7.79 $ или 8.49 $). Вот мы и столкнулись с двухфакторным экспериментом.

Отметим, что такой эксперимент нужно проводить 4 раза (например, каждый понедельник). Недостаточно просто менять по одному признаку (3 эксперимента), нужно добавить еще один - когда меняются оба признака сразу. Это увеличит количество полученной информации в 2 раза и позволит провести сравнение влияния обоих признаков на результат эксперимента. Дальше мы увидим почему это так.

При планировании эксперимента составляют специальную таблицу (табл. 2). Порядок записи данных в таблице называется стандартным порядком испытаний.

Таблица 2. Пример записи результатов эксперимента.

| No | real No | Dimmer, % | Price | Profit, $ |

|---|---|---|---|---|

| 1 | 3 | 50 | Low | 490 |

| 2 | 1 | 75 | Low | 570 |

| 3 | 4 | 50 | High | 370 |

| 4 | 2 | 75 | High | 450 |

Даже просто записав получившиеся результаты, мы можем начать их анализ. Например, эффект яркости света при низкой цене составляет 80 $ (разница между тусклым и ярким светом). Тот же эффект при высокой цене будет 80 $. Таким образом, мы наблюдаем увеличение прибыли на 80 $ от эффекта освещения. Можно заметить, что эффект сохраняется при разных уровнях цены.

Аналогично для эффекта цены: при слабой освещенности он составит 120 $, при ярком свете - тоже 120 $. Таким образом, при увеличении цены на товар, прибыль падает (для нашего случая).

Задача. Как Вы думаете, что могло пойти не так? Какие факторы мы не учли и что еще может оказывать влияние на прибыль? Является ли наш эксперимент воспроизводимым (получим ли мы те же результаты при изменении прочих факторов)?

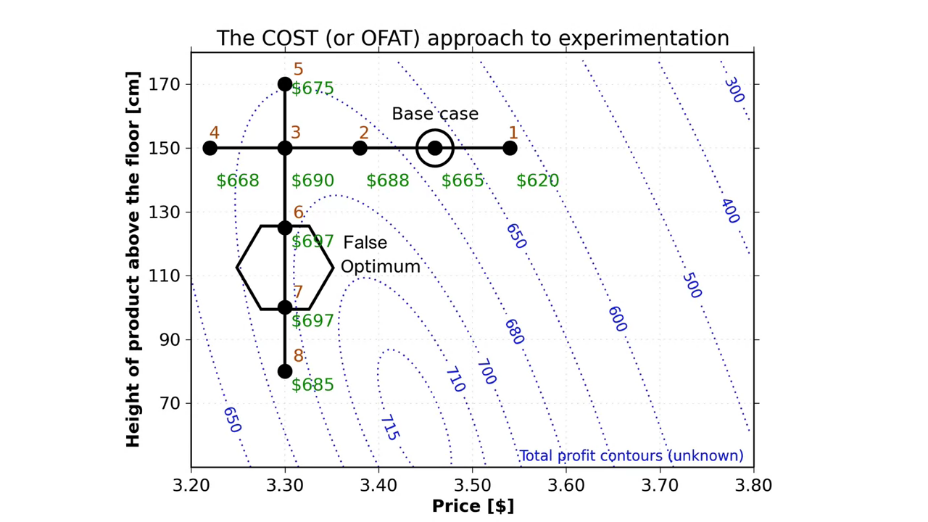

Интересно, что для рассмотренного примера многие люди провели бы не 4, а 3 опыта в рамках эксперимента. В качестве первого опыта они выбрали бы слабую освещенность и низкую цену. Далее, они бы проведи второй опыт - увеличили яркость света (оставив неизменной цену). Затем, они вернулись бы к начальной точке и провели бы третий опыт, увеличив только цену.

Многие посчитают, что так и надо проводить эксперименты (потому что каждый раз вы меняете только один фактор). Вас учили этому в школе и университете. Менять только один параметр за раз. Но в общем случае так делать не надо!

Если вы ограничитесь тремя экспериментами, вы получите только одну оценку эффекта от освещенности и только одну оценку эффекта от цены. Однако, всего один дополнительный опыт при увеличении обоих факторов позволит нам оценить оба эффекта дважды. Мы получаем две оценки влияния освещенности и две оценки влияния цены на прибыль. Поэтому, добавив всего один дополнительный опыт, мы фактически удвоили количество полученной информации.

Во многих случаях, этот дополнительный опыт стоит затраченных усилий.

Примечание. Мы описали так называемый "полнофакторный" эксперимент (full factor experiment). при этом мы изменяли сразу оба параметра. Однако пример "фиксированного" подхода к эксперименту (когда мы меняем только один фактор при фиксированных прочих факторах) очень распространен в аналитической химии. В случае построения градуировочной прямой мы меняем обычно только одну переменную (аналитический сигнал) в фиксированных условиях и измеряем только один отклик (концентрацию). Как Вы думаете почему? Какую дополнительную экспериментальную работу необходимо сделать, прежде чем станет возможно зафиксировать остальные факторы?

Немного терминов для словарного запаса. Множество наших наблюдений за объектом есть процесс измерения. В свою очередь запись измерения в определенных величинах — это количественный анализ/измерение (сравнение с установленным стандартом, например, измерение линейкой). Таким образом, количественное измерение — записанный результат сравнения в определенной размерности. Качественный анализ — просто результат сравнения (больше или меньше, есть объект или нет, как правило без размерности). Иногда говорят о полуколичественном анализе, подразумевая не очень точный количественный анализ (но лучше, чем ничего).

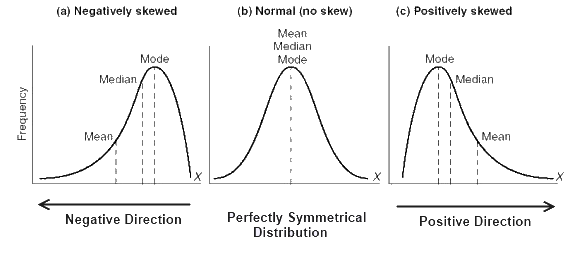

2.1.1 Точность и воспроизводимость

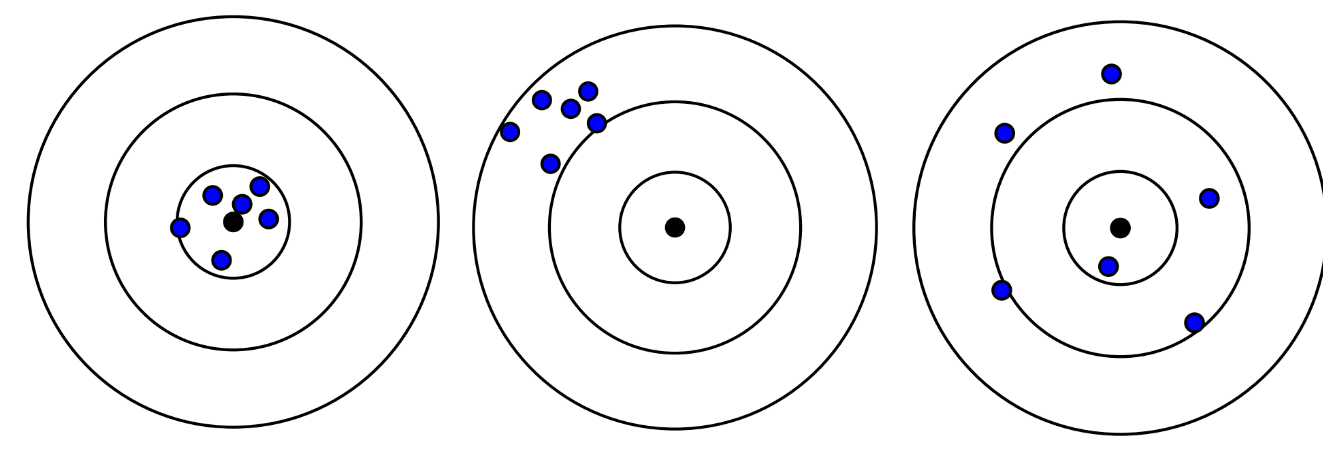

Мы подошли к основным понятиям обработки результатов эксперимента: точность (прецизионность, accuracy) и воспроизводимость (precision). Лучше всего эти понятия объясняет аналогия с мишенями для стрельбы (рис. 2).

|

Рис. 2. Примеры с точностью и воспроизводимостью стрельбы. Точно и воспроизводимо, не точно и воспроизводимо и "точно" и не воспроизводимо (когда среднее значение не точных результатов оказывается случайно близким к истинному значению). |

Точность определяет близость полученного результата к абсолютному значению, а воспроизводимость — насколько близко от предыдущего полученного результата будет лежать следующее такое же измерение. Воспроизводимость и точность оцениваются с помощью очень важного и полезного инструмента — статистики (область математики).

Для оценки точности полученного результата мы можем использовать понятие абсолютной и относительной погрешности.

Абсолютная погрешность (absolute error): \(a = x_{true} − x_{our}\), где: \(x_{true}\) — истинное значение (как правило никогда не известно, поэтому за него обычно принимаем значение референтного метода анализа или среднее), \(x_{our}\) — полученное нами значение. Как можно заметить по формуле, абсолютная погрешность измеряется в тех же величинах что и само измерение.

Относительная погрешность (relative error): \(\Delta = \frac{x_{true} - x_{our}}{x_{true}}\). Относительная погрешность измеряется в процентах (на то она и относительная).

Воспроизводимость в свою очередь определяется немного сложнее и к ней мы вернемся в 3 части курса, посвященной статистической обработке результатов.

Стоит сказать, что существует всего 2 природы погрешности: случайная (random, обусловленная статистической природой измерений, всегда присутствует в нашем несовершенном мире) и систематическая (systematic), обусловленная действием какой-либо постоянной возмущающей силы, которую можно вычислить или учесть (например, гравитация, плохо откалиброванный прибор и т.д.).

Примечание. Распространенность "фиксированного" подход в аналитической химии вызвано тем, что он обеспечивает большую точность и достоверность полученных результатов. Однако, прежде чем выбрать наиболее значимый фактор и зафиксировать все остальные, необходимо тщательно изучить систему. Для этого и используется факторный эксперимент. Кроме того, факторный эксперимент доминирует в остальных областях знаний, включая химическую технологию.

2.1.2 Немного о правилах представления результата

Важным понятием любой естественной науки является понятие значащих цифр и правил округления. Помимо размерности, точности и воспроизводимости, нужно правильно оценить количество значащих цифр для полученных экспериментальных данных. Другими словами, нужно показать сколько цифр в полученном результате имеют реальное физическое обоснование (физический смысл). Прочие цифры нужно отбросить (точности мы не потеряем, но цифры станут достоверными).

Количество значащих цифр определяет погрешность эксперимента (и наоборот, результат измерения округляется до того же знака, что и абсолютная погрешность с одной значащей цифрой).

Пример. Если в ходе повторения эксперимента по измерению концентрации стандартного образца с установленной концентрацией в 100.0 моль/л мы получили значение 100.1, 99.8, 100.2, то средняя абсолютная погрешность составит \(\frac{\sum |x_i - 100|}{3} = \frac{0.1 + 0.2 + 0.2}{3} = 0.16666.. \approx 0.2\). Тогда средний результат измерения будет \(\frac{100.1 + 99.8 + 100.2}{3} = 100.0333... \approx 100.0\).

Обычно такой результат записывают в виде \(100.0 \pm 0.2\). Последняя цифра при такой записи получается как бы не точно определена и может принимать любое значение в пределах экспериментальной погрешности \(x \in [99.8; 100.2]\).

Значащие цифры очень полезны для естественных наук. Они позволяют упростить некоторые стадии эксперимента и сделать его более воспроизводимым, показать коллегам с какой точностью мы проводили исследования. Например, зная необходимую точность эксперимента и значащие цифры, можно рассчитать с какой точностью нужно взвешивать реактивы (если точность эксперимента ограничена 2 значащими цифрами, то взвешивать с 4 значащими цифрами нет смысла).

Далее мы приведем наборы правил для значащих цифр. Чтобы их понять и запомнить нужно мыслить категориями погрешности. Всегда помните, что последняя значащая цифра несет в себе неопределенность от абсолютной погрешности.

Для записи значащих цифр есть несколько правил.

- Каждая цифра, отличная от 0 - значащая (например, 237 — 3 значащих цифры, 129.7 - 4 значащие цифры).

- 0 перед не 0-ми числами — не значащий (0.0165 — 3 значащие цифры). В таком случае лучше применять "научную" запись числа: \(1.65 \cdot 10^{-1}\).

- 0 до десятичной точки — нельзя сказать наверняка, так ученый писать не должен (10 писать нельзя, записывать нужно как \(1.0 \cdot 10\). Однако к сожалению, такая запись очень часто встречалась в моей практике. Если вы встретили запись эксперимента в виде 3700 единиц, то скорее всего человек не знаком с практикой значащих цифр и просто округлил до целого. Лучше проанализировать эксперимент и установить количество значащих цифр (например, точность взвешивания или абсолютную погрешность).

- В остальных случаях 0 - значим (85.950 — 5 значащих цифр, 12.06 — 4 значащих цифры).

Примечание. Научная (экспоненциальная) запись числа всегда подразумевает одну цифру до десятичной точки и точное указание значащих цифр, например, \(1.650 \cdot 10^{-10}\) или \(2.740 \cdot 10^{5}\). Настоятельно рекомендую всегда пользоваться ею в экспериментальной практике.

Пример. Масса образца равна 0.1 г. Если взвешивание проводили на аналитических весах с погрешностью \(\pm 0.0001\) г, то правильное представление результата будет 0.1000 г или \(1.000 \cdot 10^{-1}\) г.

Также есть правила для арифметических действий со значащими цифрами, которые позволяют нам сохранить физический смысл величин при математических вычислениях в естественных науках.

- Сложение/вычитание — мыслите абсолютными категориями (важен порядок числа). Оставляют столько цифр после запятой, сколько их содержится в слагаемом с наименьшим числом десятичных знаков (т.е. точность лимитируется числом, имеющим наибольшую абсолютную недостоверность). Помните, что последняя цифра несет неопределенность, которая ограничивает все остальное, но при сложении ее влияние будет пропорционально ее порядку.

- Умножение/деление — мыслите относительными категориями (при умножении или делении недостоверность лимитирующего числа пропорционально переноситься на результат). Количество значащих цифр результата будет равно минимальному количеству значащих цифр участников (т.е. точность лимитируется числом, имеющим наибольшую относительную недостоверность). Если число значащих цифр одинаково, то лимитирует точность то, у которого мантисса меньше (абсолютная величина, равная всем выписанным подряд числам).

Пример. При \(0.0304 \times 5.43\) точность лимитирует первое (мантисса 1-ого 304, мантисса 2-ого 543). Это работает, поскольку относительная погрешность у меньшего числа будет больше.

- Логарифмирование - логарифмируемое число и мантисса (в случае логарифмирования - результат логарифма) содержат одинаковое количество значащих цифр.

Пример. Рассчитаем значение pH \(2.0 \cdot 10^{-3}\) М раствора HCl. Учтем, что основание логарифма и степени 10 в экспоненциальной записи числа - точные величины. Тогда результат:

$$ pH(2.0 \cdot 10^{-3}) = -lg(2.0 \cdot 10^{-3}) = -(lg(2.0) -3) = -(0.30 - 3) = 2.70 $$Обратите внимание, что за счет сложения с абсолютно точной величиной 3, точность конечного результата составила 3 значащих цифры (абсолютная погрешность измерения осталась прежней, а вот относительная погрешность уменьшилась).

- Возведение в степень - множественное умножение чисел, с одинаковым количеством значащих цифр и число значащих цифр результата будет таким же.

- Корень числа - можно представить как результат в абсолютной степени, т.е. множественное умножение результата, которое даст число, возводимое в корень. Таким образом число значащих цифр останется неизменным.

- Соблюдаем арифметический порядок действий как в математике.

- Во избежание накопления ошибки, округление результата делается только в конце всего вычисления. В промежуточных расчетах оставляем количество значащих цифр + 1. В конечном результате эта дополнительная цифра округляется.

Примечание. Приведенные правила вычислений со значащими цифрами есть не что иное, как приближение для погрешности результата. По этой причине чрезвычайно не желательно производить много расчетов для величин с погрешностями (особенно возведение в степень, взятие корня и логарифмирование) - чем больше таких операций, тем более не определен наш конечный результат в действительности. Правила обращения со значащими цифрами при математических операциях можно строго обосновать на основе закона распространения погрешностей (но делать так мы конечно же не будем).

Примечание. Результаты грави- и титриметрических определений в большинстве случаев записывают в виде чисел, содержащих 4 или 2 значащие цифры, что связано с погрешностью измерения массы веществ (например, \(\pm 0.0001\) г) и объемов (например, \(\pm 0.03\) мл) растворов. Но количество значащих цифр сильно зависит от исходной массы навески.

Примечание. Результат анализа и его погрешность должны содержать одинаковое число знаков после запятой (например, \(10.1 \pm 0.1\)).

Правила округления:

- округляем до количества значащих цифр (последняя несет в себе неопределенность);

- если отбрасываемая цифра больше пяти или меньше — округляем в соответствующую сторону;

- если отбрасываемая цифра 5 — округляем до ближайшего четного (если нужно округлить только одну цифру 5: \(10.5 \approx 10\), но это не так, если округляем 2 цифры \(10.51 \approx 11\));

- не округляем промежуточные вычисления или оставляем нужное количество значащих цифр + 1.

- всегда помните, что значащие цифры это показатель абсолютной погрешности измерения величины и работать с ними нужно соответственно.

Подводя итог еще раз рассмотрим зачем нам нужно всегда использовать значащие цифры, а не писать все что выводит нам калькулятор.

-

Являются достоверными и позволяют определять точность операций.

-

Можем определить лимитирующую стадию эксперимента (где наш эксперимент наименее точен и что в эксперименте стоит улучшить).

-

Показывают физический смысл округления чисел.

Пример. Необходимо рассчитать результат вычисления:

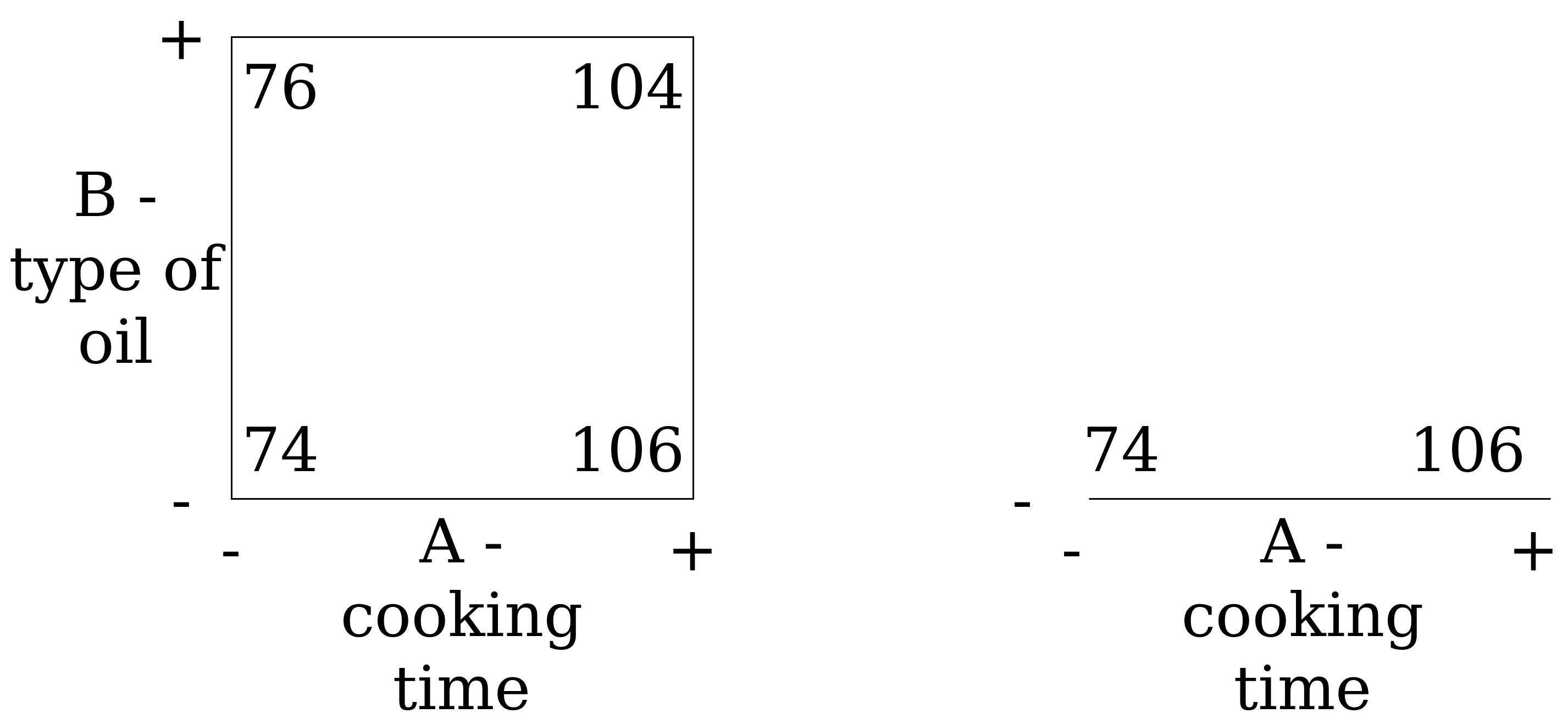

2.2 Анализ двухфакторного эксперимента

Я надеюсь, что смог показать вам как нужно записывать результаты экспериментов и убедил вас в значимости факторных экспериментов в нашей жизни. Время перейти к их изучению и анализу.

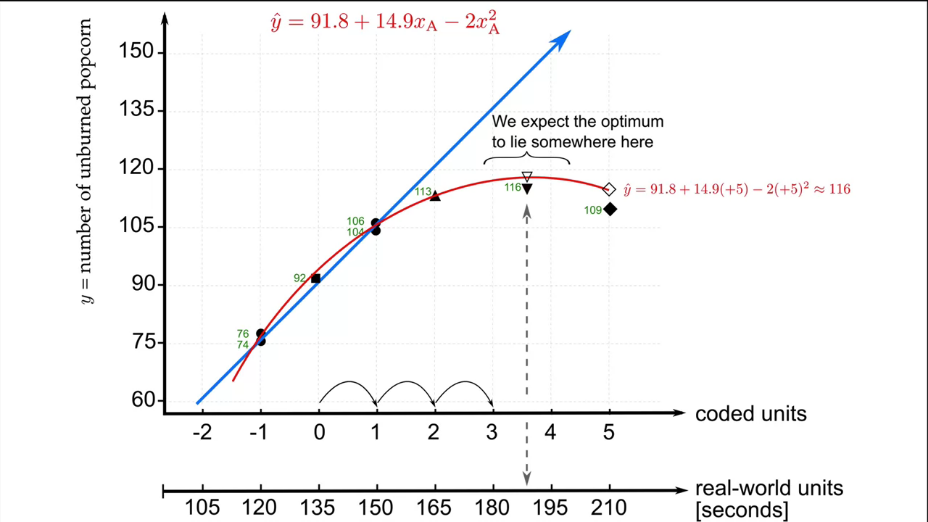

В качестве примера рассмотрим попкорн. Мы будем стараться оптимизировать количество лопнувших зерен. Этот эксперимент хорош тем, что вы можете повторить его у себя дома.

Примечание. Если что-то будет непонятно, то можете смело писать мне или посмотреть курс, где данный эксперимент разобран более подробно.

В самом эксперименте у нас будут 2 исследуемых фактора, которые принимают по 2 значения: А - время нагрева (160 и 200 с) и В - тип попкорна (желтый и белый). Можно легко посчитать, что число экспериментов будет 4.

Примечание. В общем случае для расчета количества экспериментов используют следующую формулу: \(f^v = 2^2 = 4\), где \(f\) - число факторов, а \(v\) - число значений, принимаемых фактором (согласно еще одной области математике - комбинаторике). В нашем случае мы всегда будем рассматривать одинаковое число уровней у факторов, считайте это своего рода требованием для подобных планов экспериментов.

Составим таблицу эксперимента (табл. 3). Обозначим низкое и высокое значение фактора как - и + соответственно (для категориального - не важно, выбираем любой). Тогда для А: - = 160, + = 200, для В: - = белый, + = желтый.

Примечание. Для получения информативных результатов важно:

- не использовать экстремальных значений для факторов (иначе на них оказывается множество влияний и они слишком сильно будут отличаться друг от друга, что увеличит погрешности);

- всегда проводить эксперименты в случайном порядке! Только так мы сможем избавиться от систематической погрешности и возникающих дополнительных связях между величинами.

Таблица 3. Результаты двухфакторного "попкорн-эксперимента".

| Standard order | Random order (real) | A - time * | B - corn | Results |

|---|---|---|---|---|

| 1 2 3 4 |

3 1 4 2 |

- + - + |

- - + + |

52 74 62 80 |

* используем стандартный подход: сначала все время изменяем 1-ый фактор, а 2-ой ставим ему в соответствие.

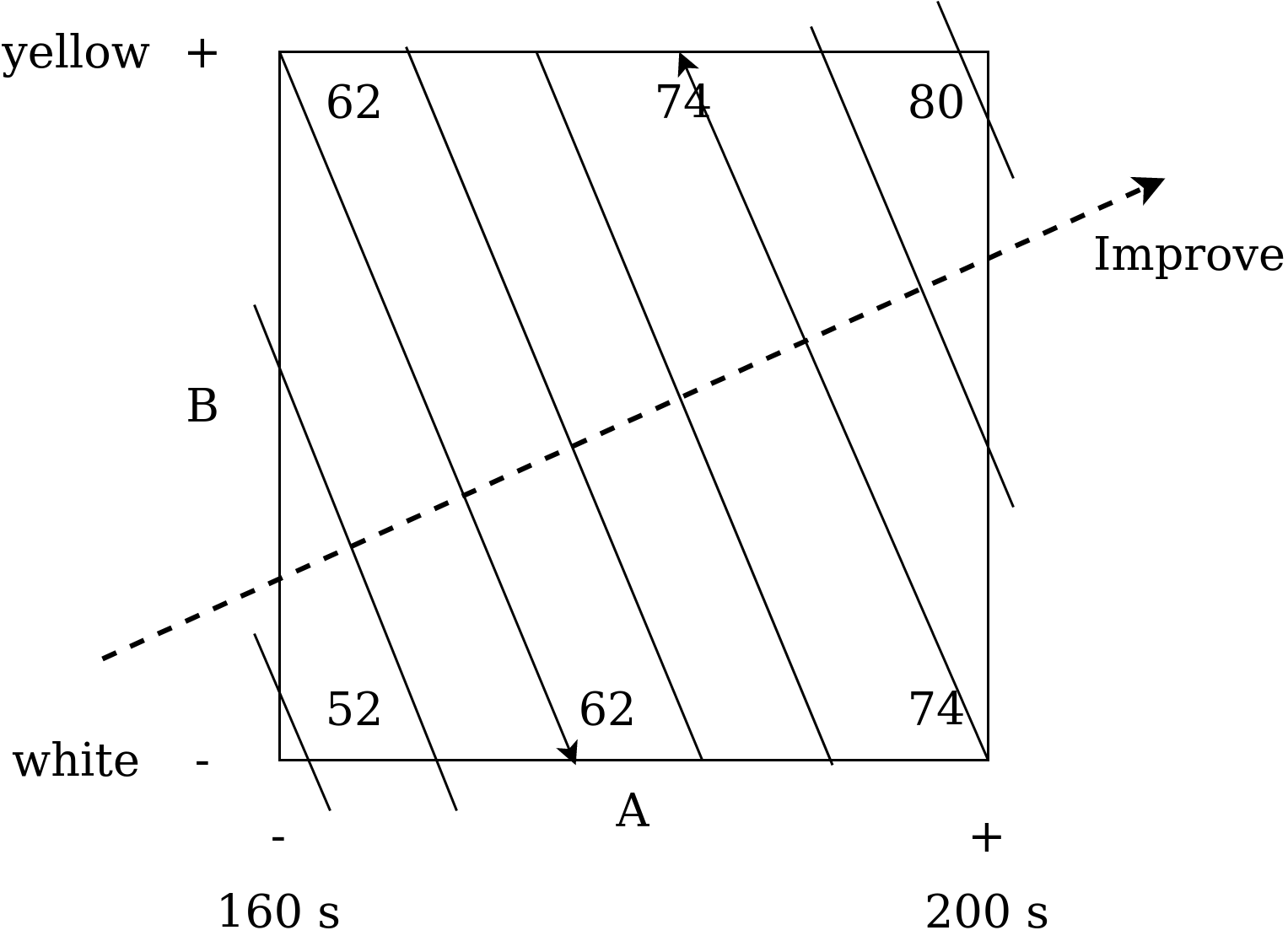

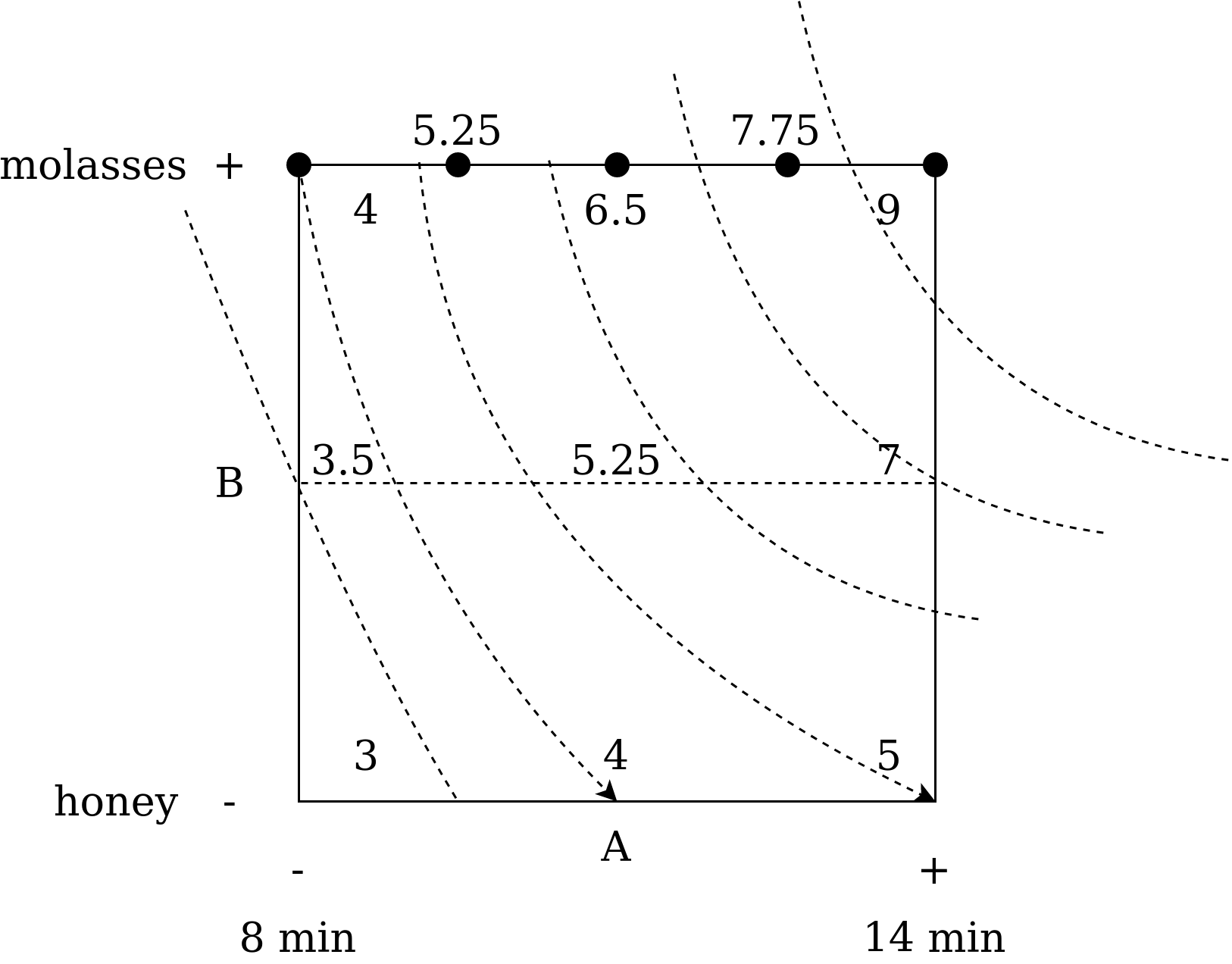

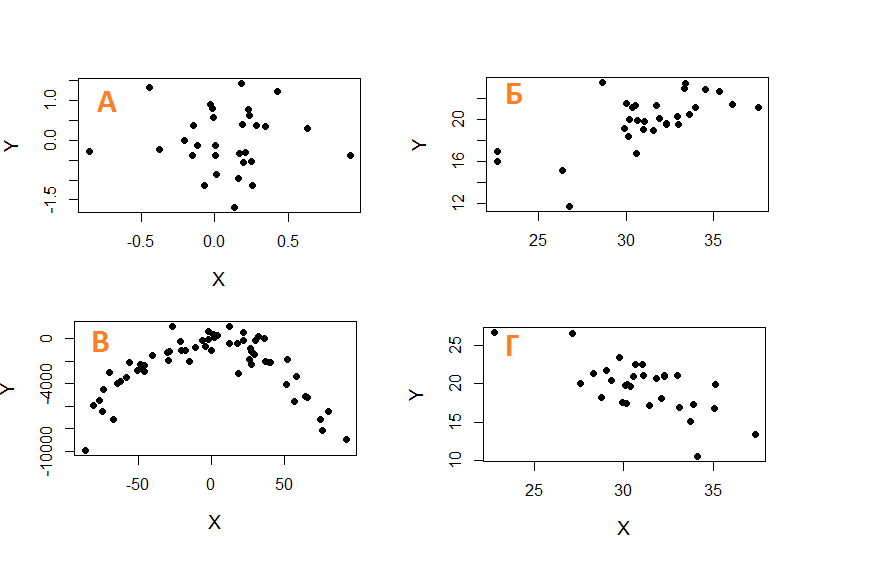

Итак, результаты получены. Само время проводить анализ. Начинать всегда лучше всего с визуализации (так уж устроено наше мышление). Визуализация факторного эксперимента называется кубической диаграммой (графиком/планом, cube plot). Она приведен на рис. 3.

|

Рис. 3. Кубическая диаграмма 2-ух факторного эксперимента с попкорном. На диаграмме изображены изолинии. |

Эта диаграмма показывает эффект от каждого фактора в соответствующем углу квадрата или куба (2 или 3 факторные эксперименты).

Начнем с оценки эффекта от времени. При увеличении времени готовки для желтого попкорна, результат увеличивается с 62 до 80 лопнувших зерен (ЛЗ). Мы видим рост на 18 единиц. Для белого попкорна мы видим изменение с 52 до 74 ЛЗ, то есть рост на 22 единицы. Итак, в среднем мы видим увеличение на 20 единиц при увеличении продолжительности нагрева со 160 до 200 секунд.

Далее давайте оценим разницу между двумя типами попкорна. Зафиксируем время нагрева и посмотрим на эффект от перехода от белого к желтому попкорну: с 74 до 80 для 200 с и с 52 до 62 для 160 с. В среднем мы видим увеличение на 8 единиц при переходе от белого к желтому попкорну. Убедитесь, что ваша интерпретация соответствует кубической диаграмме. Эта визуализация очень важна для самопроверки результатов анализа.

Но помимо результатов, на кубической диаграмме отображены еще и контурные линии (contour plot, их еще называют изолиниями, isolines). Они обозначают область, в которой значение измеряемого признака остается постоянным (на 1 линии количество лопнувших зерен будет постоянным). Их рисуют начиная с любого угла кубической диаграммы, значение в котором не является максимальным или минимальным. Затем ищут это же значение на противоположенной стороне квадрата и проводят линию в соответствии с предполагаемым уровнем результата. Для проверки кривизны линии нужно рассчитать наше фиксированное значение для середины шкалы.

Затем рисуем вторую линию аналогично для значения в 74. Остальные рисуем параллельно полученным линиям.

Благодаря изолиниям можно быстро понять, куда начинать движение для оптимизации результата, т.е. по направлению к нашей цели. Например, если цель — максимизировать количество лопнувших зерен, то двигаться нужно перпендикулярно изолиниям в верхний правый угол. В данном случае это означает, что мы должны взять желтый попкорн и увеличить время приготовления (что вполне интуитивно понятно из кубической диаграммы).

Такой подход к оптимизации (с использованием изолиний) помогает нам определиться с метом проведения следующего эксперимента. Контурная диаграмма - это наш градиент (gradient, путь, по которому пройдут наши эксперименты для подтверждения/опровержения закона или теории).

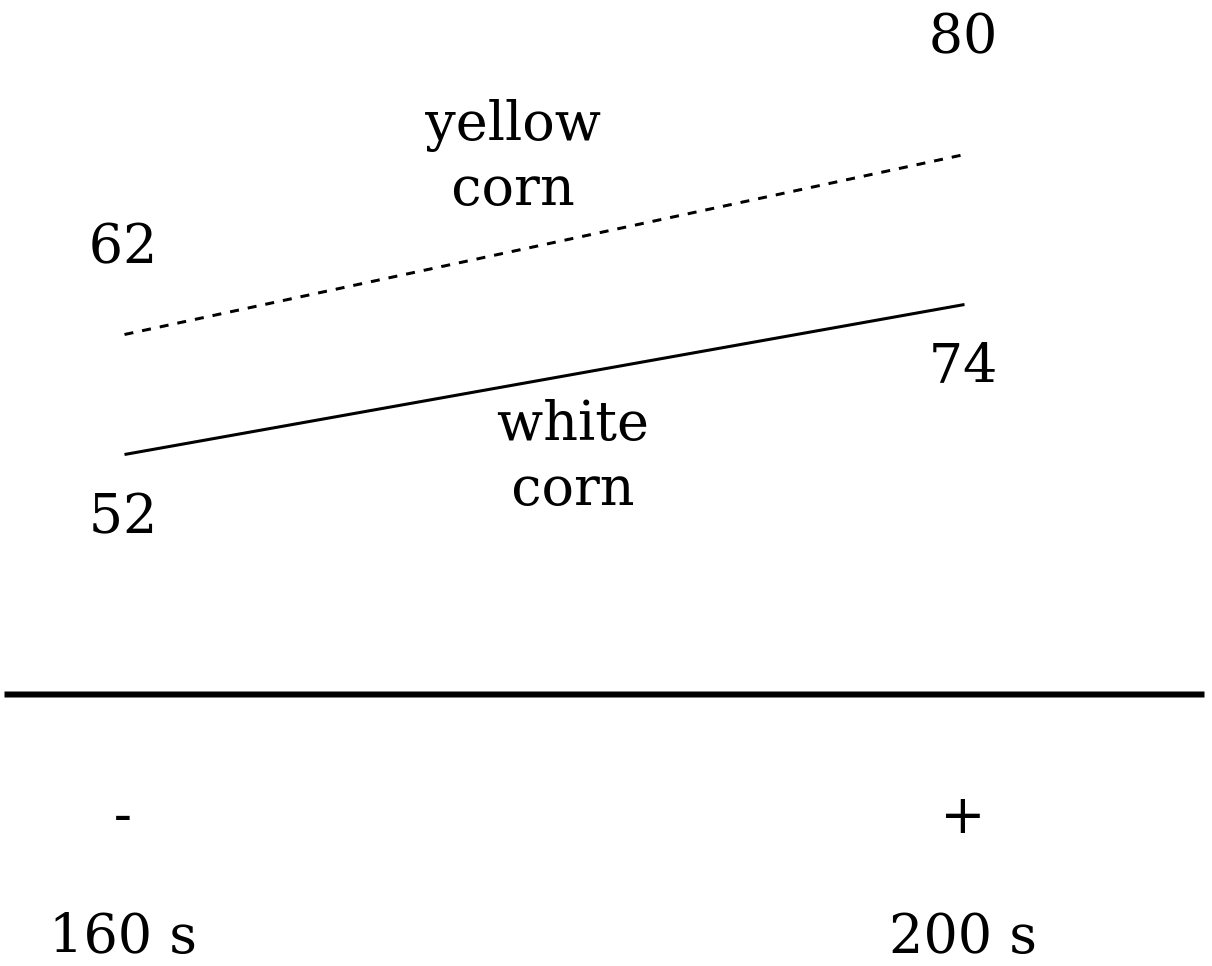

Отмечу, что есть еще один способ визуализации - диаграмма взаимодействия (interaction plot) (рис. 4).

|

Рис. 4. Диаграмма взаимодействия для 2 факторного эксперимента с попкорном. |

Обратите внимание, что эти две линии практически параллельны, что означает, что в исследуемой системе практически отсутствует взаимодействие. Выбор переменной для диаграммы взаимодействия не играет большой роли и мы могли бы выбрать другую переменную для обозначения на горизонтальной оси.

Для всех описанных методов визуализации не требуется какое-либо программное обеспечение. Вы можете использовать эти методы визуализации как для числовых, так и для категориальных факторов. Все это демонстрирует явное преимущество такого подхода к эксперименту: мы можем быстро интерпретировать результаты, используя простые графические инструменты, элементарную математику и лист бумаги.

Тот факт, что все так просто, означает, что результатами будет легко поделиться с менеджерами или коллегами на работе.

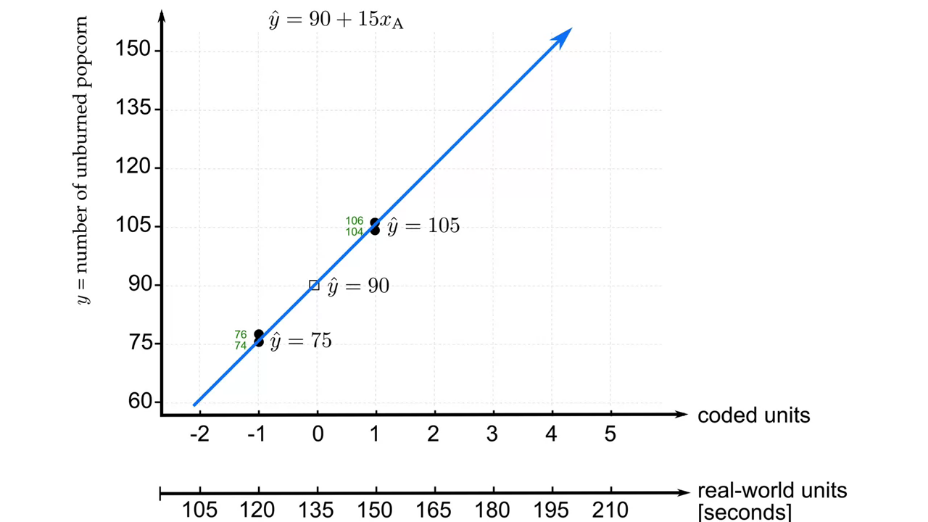

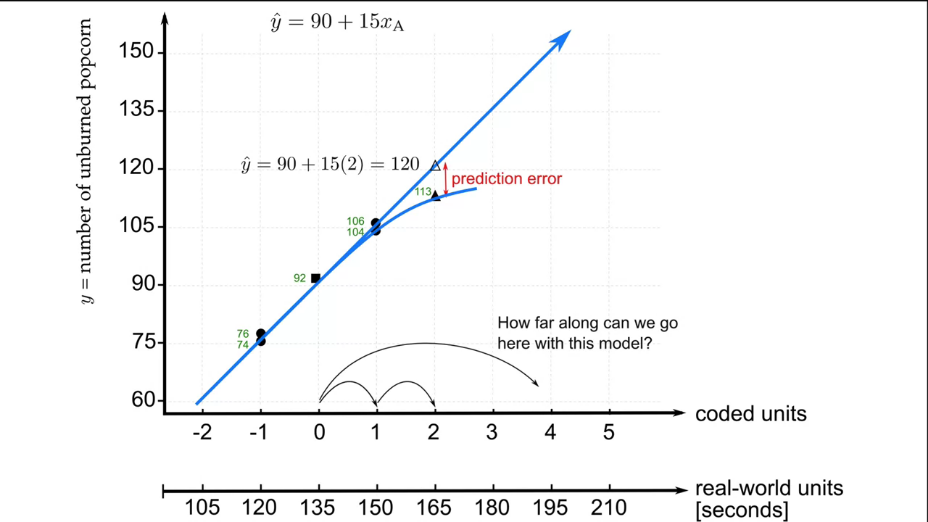

2.3 Построение прогнозов

Мы рассмотрели пример планирования, проведения и анализа эксперимента. Но что это нам дает? Как мы можем представить и использовать полученные данные? Ответ - построить прогноз (модель, уравнение регрессии). В рамках нашего курса мы будем рассматривать только линейные модели (за небольшим исключением). Такие модели наиболее универсальные (любую гладкую и монотонную функцию можно представить как набор линейных отрезков).

В случае нашего "попкорн-эксперимента" (2-ух факторный эксперимент), полученная модель состоит из 3 частей:

где,

- \(a_0\) - базовый результат (intercept), который мы ожидаем увидеть при отсутствии влияния (когда закодированные значения факторов = 0). Этот коэффициент рассчитывается как среднее из 4 значений на кубической диаграмме (т.е. ее центр).

- \(a_1\) - коэффициент влияния фактора А (его закодированного значения), зависит от времени приготовления. Рассчитывается как средняя нормированная разница между высоким и низким значением фактора: \(a_1 = \frac{\frac{(80-62) + (74-52)}{2}}{2}\). Обратите внимание, нормировка подразумевает расчет коэффициента для единичного изменения фактора (т.е. с -1 до 0 или от 0 до +1), поэтому мы должны разделить усредненное значение на 2.

- \(a_2\) - коэффициент влияния фактора В, зависящий от типа зерен. Рассчитывается аналогично пункту 2.

Учитывая приведенное описание наша модель будет:

Задача. Проверьте корректность прогнозов этого уравнения для различных значений переменных A и B. Обращайте внимание на изолинии!

2.4 Взаимодействие между факторами

До сих пор мы рассматривали весьма идеальные случаи где нет взаимного влияния факторов друг на друга и на целевую переменную. Однако зачастую это не так.

Пример. Мы пытаемся отмыть руки и проводим 2-ух факторный эксперимент: есть/нет мыла и теплая/холодная вода. Можно заметить, что эффект теплой воды усилится при использовании мыла. И наоборот, эффект мыла усилится при использовании теплой воды. То есть "взаимодействие" говорит о том, что эффект одного фактора зависит от уровня другого фактора.

Кроме этого, эти взаимодействия обычно симметричны (не не всегда!). Т.е. нет разницы будем ли мыть руки в теплой воде с мылом или с мылом в теплой воде, результат будет одинаков.

Первым показателем наличия взаимосвязи является несимметричность линий на диаграмме взаимодействия или изогнутость изолинии на кубической диаграмме. Если вы наблюдаете такие эффекты, то это проявляется двухфакторное взаимодействие (когда поведение одной переменной сильно отличается в зависимости от уровня другой переменной).

Рассмотрим эксперимент на рис. 5 и рассчитаем все коэффициенты. Эксперимент заключался в анализе влияния времени выпечки (фактор А) и типа подсластителя (фактор В) на вкус печенья (по шкале от 1 до 10).

|

Рис. 5. Кубическая диаграмма эксперимента со взаимодействием признаков. |

Обратите внимание, что изолинии уже не параллельные и изображать их нужно в изогнутом виде (еще раз напомню, на изолинии должно быть одинаковое значение результата). Для этого рекомендую провести вспомогательную линию по центру кубической диаграммы.

Выраженная не параллельность линий сигнализирует о наличии взаимного влияние факторов друг на друга. Строго говоря, при анализе эксперимента нужно всегда строить модель с учетом взаимного влияния и исключать его только если коэффициент перед этим фактором в модели очень мал. Рассчитаем получившуюся модель.

Для начала рассчитаем влияние каждого фактора на эксперимент в отдельности (без учета взаимного влияния, аналогично предыдущему примеру).

Затем, учтем фактор взаимного влияния, рассчитав изменения при одном фиксированном факторе (тип подсластителя). Тогда, математически, взаимодействие рассчитывается как усредненная разница при высоком и низком значении признака:

Это значение нормируется на единицу изменчивости фактора (уже классический прием).

Проверим симметричность влияния, зафиксировав другой фактор:

Таким образом влияние действительно симметрично и равнозначно. В итоге, наша модель запишется в виде:

Задача. Постройте диаграмму взаимодействия факторов и убедитесь в наличие взаимодействия. Проверьте точность предсказания нашей модели для краевых значений и различной времени готовки без учета взаимного влияния и с учетом взаимного влияния.

2.5 Трехфакторный эксперимент

После того, как мы освоили азы анализа результатов эксперимента, мы можем усложнить исходные условия.

Новый пример взят из учебника Бокса, Хантера и Хантера, которая называется "Статистика для экспериментаторов". В этом эксперименте проводится поиск оптимальной комбинации параметров для уменьшения количества загрязнителя в сточных водах очистных сооружений.

Рассматривается три фактора с 2 уровнями.

- Первый фактор — С (chemical), химическое соединение (два соединения P и Q).

- Следующий фактор - T (temperature), температура очистки воды (\(72^o F, $100^o F\)).

- Последний фактор - S (stirring speed), это скорость перемешивания (200 или 400 оборотов в минуту).

Тогда количество необходимых экспериментов составит:

где \(f\) - число факторов, а \(v\) - число значений, принимаемых фактором.

Результатом эксперимента будет количество загрязняющих веществ, измеренное в фунтах.

Используя стандартный порядок проведения эксперимента, составим таблицу эксперимента (табл. 4).

Таблица 4. Результаты трехфакторного эксперимента.

| Standard order | Random order (real) | C - chemical | T - time | S - stirring speed | Outcome |

|---|---|---|---|---|---|

| 1 2 3 4 5 6 7 8 |

6 2 5 3 7 1 8 4 |

- + - + - + - + |

- - + + - - + + |

- - - - + + + + |

5 30 6 33 4 3 5 4 |

Одно из преимуществ такой таблицы заключается в том, что мы можем быстро получить общее представление о влиянии фактора на результат. Например, оцените как изменяется количество загрязняющих веществ, когда мы меняем фактор химического соединения C? Уровень фактора меняется с низкого на высокий и мы видим ту же самую картину с количеством загрязняющих веществ. Посмотрите на эффект фактора S. Первые четыре эксперимента в среднем показали очень высокий уровень загрязнения, а последние четыре эксперимента — низкий уровень загрязнения.

Просто глядя на таблицу, мы можем сказать, что факторы C и S скорее всего важны для понимания полученных результатов.

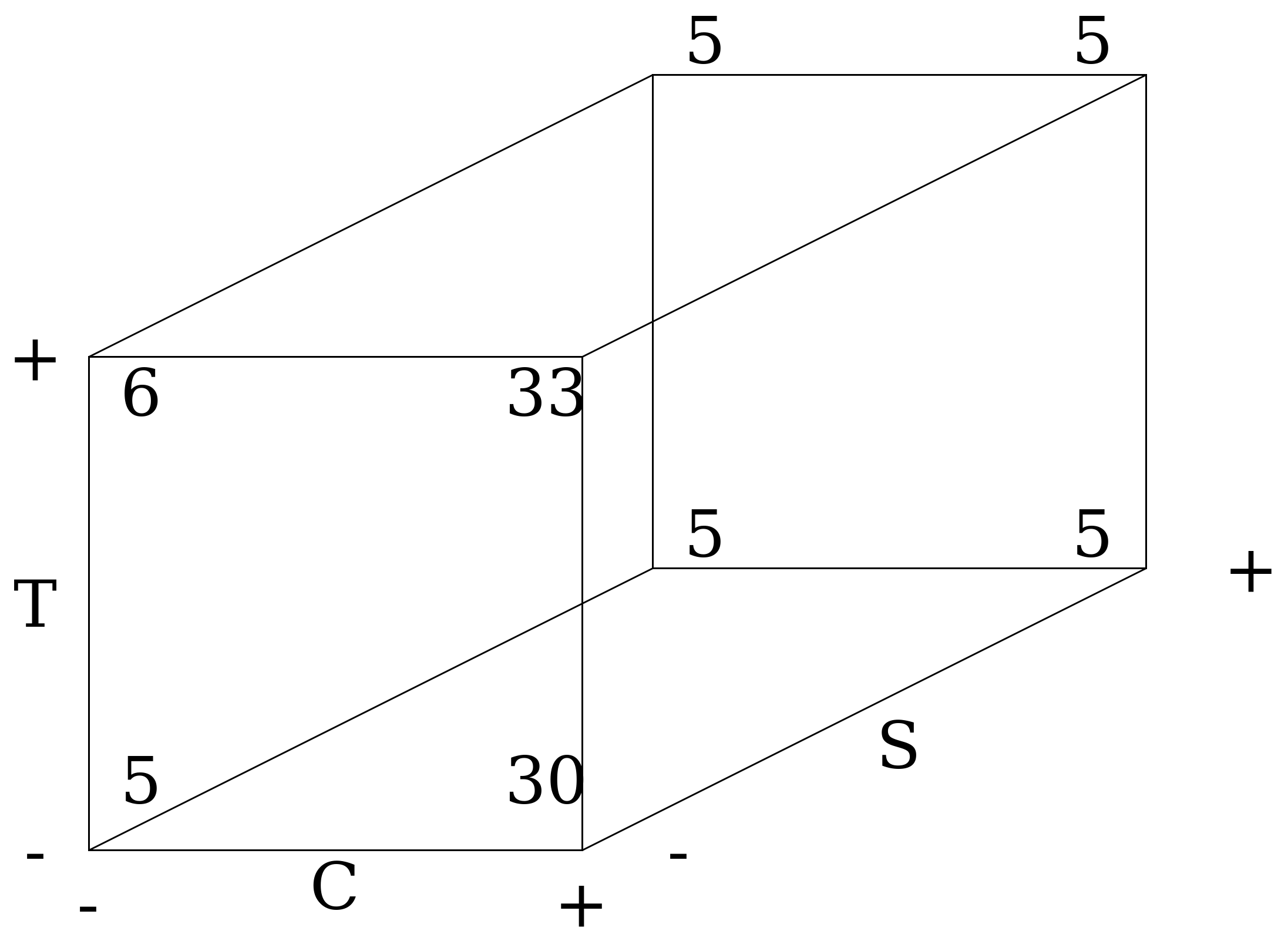

На основании таблицы эксперимента составим кубическую диаграмму (рис. 6.)

|

Рис. 6. Кубическая диаграмма трехфакторного эксперимента. |

Общий вывод. Согласно полученным результатам, нам нужно взять химикат Q, проводить очистку при низкой температуре и на высокой скорости перемешивания (400 оборотов в минуту).

Проанализируем основные эффекты и взаимодействия.

Начнем с первого фактора C (выбора между химическими соединениями P и Q, где Q — высокий уровень фактора). Из кубической диаграммы мы можем получить четыре оценки эффекта С (вдоль каждого из четырех горизонтальных ребер). При высокой температуре и высокой скорости перемешивания (т.е. высокий уровень T и высокий уровень S) эффект от этого фактора равен 4-5 фунтов загрязнения. При высокой температуре и низкой скорости: 33-6. При низкой температуре и высокой скорости (т.е. Т - и S +), эффект равен: 3-4. И, наконец, при низкой температуре и низкой скорости: 30 и 5.

Мы можем проанализировать полученную информацию с точки зрения каждого фактора и их возможного взаимодействия.

-

В ходе опытов, химическое соединение показало четыре результата. Среднее для этих четырех чисел равно \(\frac{50}{4} = 12.5\). Но что на самом деле означает полученное число 12.5? Как бы вы объяснили это значение своему менеджеру, который ничего не смыслит в статистике и экспериментах?

-

Значение в 12.5 говорит о том, что в среднем мы ожидаем увидеть увеличение количества загрязняющих веществ на 12.5 фунтов на тонну при переходе от химического соединения P к Q (хотя для модели используется коэффициент 6.25 - половина). Таким образом для категориальных признаков в модели мы пишем половину от эффекта (учитываем нормировку).

-

Еще одна вещь, на которую следует обратить внимание, это расхождение эффектов химиката при высоком и низком уровне перемешивания (S). Обратите внимание на огромную разницу, которая говорит о том, что существует явное взаимодействие между фактором C и фактором S.

-

-

Прежде чем мы перейдем к взаимодействиям, давайте рассмотрим температуру (T). Заметное влияние температуры на отклик системы в таблице отсутствует. Это же подтверждает рассчитанный коэффициент в модели = 1.5 единицы (или 0.75 при нормировании эффекта). Это действительно слабый эффект.

-

Наконец, рассмотрим эффект скорости перемешивания (S). Среднее для эффекта равно -14.5 (или -7.25 при нормировке). Другими словами, мы ожидаем среднее снижение количества загрязняющих веществ на 14.5 фунтов при переходе от низкой скорости перемешивания к высокой.

На этом этапе вам всегда надо делать паузу, чтобы убедиться, что полученные результаты имеют смысл. По горизонтальной оси мы видим, что переход от химиката P к Q увеличивает загрязнение (рис. 6). Поэтому значение 6.25 выглядит адекватно. Небольшое значение 0,75 для температуры также выглядит логично, потому что она действительно имеет очень слабый эффект. И, наконец, увеличение скорости перемешивания приводит к наиболее существенному снижению загрязнения: на 7.25 единиц.

Примечание. Всегда проверяйте полученные коэффициенты модели на разумность!

Как только мы закончили с интерпретацией факторов по отдельности, можно перейти к взаимодействиям. Ранее мы отметили, что эффект химиката сильно меняется при низкой скорости перемешивания. Однако на задней грани куба (при высоких скоростях перемешивания) эффект от выбора химиката практически равен нулю. Очевидно, что скорость перемешивания изменяет эффект от химического соединения. Таким образом мы наблюдаем взаимодействие между 2 факторами S и C. Для численной оценки воспользуемся уже знакомым нам приемом - добавим новый член в уравнение.

У нас есть две возможности его рассчитать, фиксируя разные уровни переменной:

- при высокой температуре;

- вторая — при низкой температуре.

Нет гарантии, что эффект будет симметричен, поэтому произведем оба расчета, а затем возьмем среднее (даже если эффект будет симметричен мы ничего не потеряем, а в противном случае - учтем оба влияния). А потом, как и всегда, нормируем на количество уровней признака (запишем половину).

Пока что, мы учли только взаимодействие между факторами С-S. По остальным двухфакторным взаимодействиям не наблюдается видимого значимого влияния (одна из возможных причин - температура слабо влияет на модель). На самом деле, есть еще и трехфакторное взаимодействие C-T-S. Но пытаться все это учесть в ручную весьма утомительно и велик шанс наделать при этом ошибок. Далее мы будем использовать для этого компьютер. Поэтому пока остановимся на полученных результатов и проанализируем их.

Общий анализ результатов. Основное заключение - при низких скоростях перемешивания химикат Q не эффективен, но при высоких оба химических соединения одинаково эффективны. Начиная с этого момента эксперименты становятся действительно мощным инструментом. Мы увидели, что самый низкий уровень загрязнений был при использовании химиката Q с высокой S и низкой T (найдите это значение на кубической диаграмме). Но что если, согласно требованиям правительства, загрязнение должно быть меньше 10? И при этом, допустим, химикат Q стоит вдвое дороже, чем P...

На самом деле мы сейчас мысленно оценили дополнительный результат — прибыль. Не забывайте, что прибыль (или расходы) часто играют важную роль во всех системах. Поэтому вы всегда должны иметь в виду экономическую составляющую каждого угла куба.

При этом мы убедились в малом эффекте температуры. И вот в чем вопрос: значит ли это, что рассматривать температуру в качестве фактора бессмысленно? И ответ - нет. Важно понимать, что даже незначительные эффекты представляют для нас важную информацию для изучения системы. Так, в нашем примере мы видим, что в диапазоне температур \([70; 100]^o F\) температура оказывает незначительное влияние на количество загрязняющих веществ. И это важно, потому что на основании этой информации инженер или оператор может подобрать наиболее экономически выгодные условия работы. И, опять-таки, все сводится к прибыли. Вполне вероятно, что работа при более низкой температуре позволит сэкономить энергию. А поскольку температура оказывает лишь незначительное влияние на систему в целом, мы не окажем существенного влияния на уровень загрязнения если решим работать при низкой температуре. И это отличный результат.

Задание. Постройте прогноз для любого случая из кубической диаграммы и проверьте его для модели без учета влияний и с учетом влияний. В какую сторону работают взаимодействия (увеличивают или уменьшают количество загрязняющих веществ)?

Задача. Как Вы думаете, почему химическое соединение Q оказывается менее эффективным при низкой скорости перемешивания, но при высокой работает очень хорошо?

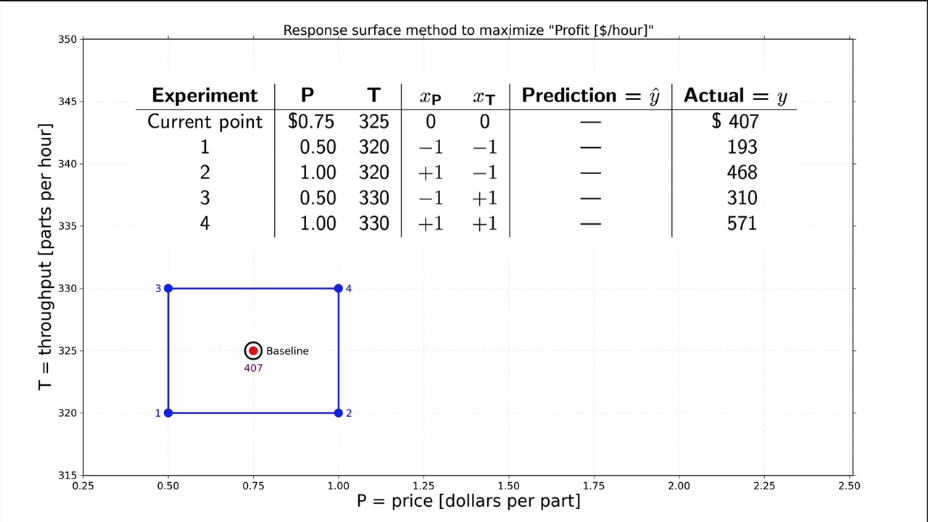

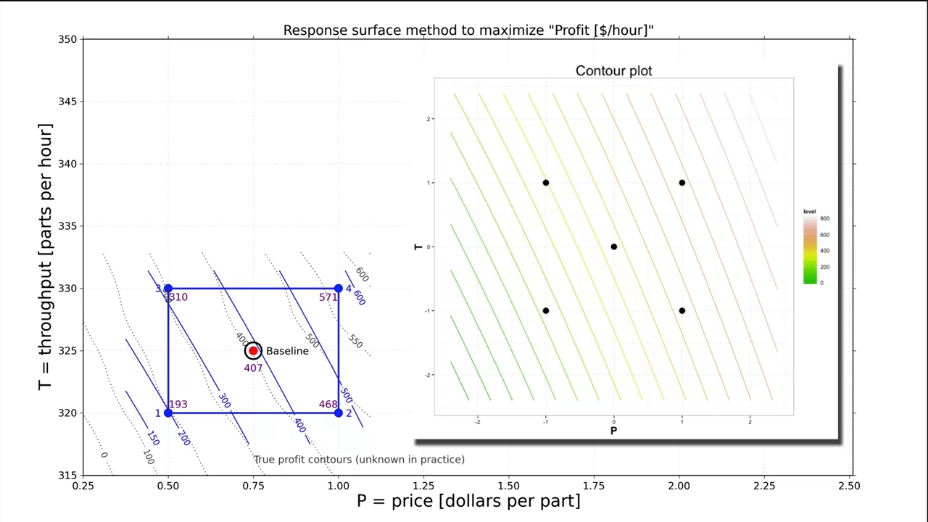

2.6 Построение модели методом наименьших квадратов (МНК) для 2 факторного эксперимента

Дойдя до этого раздела, мы рассмотрели несколько важных примеров того, как нужно строить и анализировать эксперимент. Более того, мы научились рассчитывать модель, которая позволяет связать закодированные факторы с целевой переменной. Однако, коэффициенты для модели мы подбирали интуитивно, основываясь на вполне логичных представлениях об усреднении влияний признаков. Настало время более формального описания модели по результатам экспериментов.

Для построения математически обоснованной прогнозной модели мы воспользуемся наиболее распространенным подходом - методом наименьших квадратов (МНК). Мы еще затронем статистическое обоснование данного метода в 3 главе, а пока сосредоточимся на его общих особенностях и экспериментальном применении. В качестве примера, мы будем рассматривать наш "попкорн-эксперимент". Напомню, что линейная модель для двухфакторного эксперимента в общем случае выглядит как:

при этом \(x_A\) и \(x_B\) - кодированные переменные (через значения -1 и +1 мы кодируем реальные физические величины: для А - время, а для В - тип зерен).

В нашем случае проводилось 4 опыта, для каждого из которых должна быть справедлива предложенная модель. Тогда мы можем составить систему уравнений:

Таким образом, проведя эксперимент мы имеем 4 уравнения с 4 неизвестными, а значит - можем решить их!

Эти уравнения — линейные, поэтому система уравнений достаточно просто решается с использованием матричных методов. Не стоит пугаться, это просто более удобная форма записи и метод расчета. Давайте я покажу вам, как это сделать.

В матричной форме наши уравнения записываются следующим образом:

Значения в матрице \(4 \times 4\) состоят из кодированных переменных. Остальные 2 вектора (матрицы с одним столбцом или строкой данных) состоят из результатов опытов и неизвестных нам коэффициентов перед кодированными переменными.

В так называемом "аналитическом" виде (т.е. который имеет строгое математическое обоснование), такая матричная система имеет решение:

где \(b\) и \(y\) - векторы неизвестных коэффициентов и результатов эксперимента соответственно, а \(X\) - матрица кодированных переменных (\(X^T\) - транспонированная матрица, \((X)^{-1}\) - обратная матрица).

Примечание. Факторы не всегда должны быть кодированными (могут использоваться и обычные, "реальные" значения). Однако тогда мы можем столкнуться с рядом проблем (несбалансированность величин, неустойчивость решения и т.д.). Так что лучше всегда использовать кодированные значения (или хотя бы нормированные на среднее и дисперсию).

Найти описанное решение можно и в ручную (если использовать правила линейной алгебры). Однако лучше использовать компьютерные программы, которые очень эффективно решат за вас эти уравнения. Все, что нам нужно, это матрица \(X\) и вектор \(y\). И у нас есть все необходимое: матрица \(X\) получилась из таблицы эксперимента, а вектор \(y\) — это просто результаты четырех экспериментов.

Для компьютерных расчетов мы можем использовать ряд программ. Основные из них: MS Exel, R, Python и др. Как можно заметить, 2 из 3 перечисленных мною программ - языки программирования. Но не стоит их боятся. Например R - это очень распространенный и простой язык для статистики и анализа данных. Установить и использовать его довольно легко, а результат получается наглядным. С другой стороны современный Exel предоставляет весьма широкий набор функций работы с данными (в том числе работа с моделями и базами данных, pivot tables и т.д.). Помимо этого доступно множество платных и бесплатных программ для планирования эксперимента и анализа данных. Вы можете провести их поиск в интернете. Но в рамках нашего небольшого курса мы рассмотрим довольно простые примеры на R. Кроме того, более подробно работа с R рассмотрена в этом курсе с русскими субтитрами или другом, русскоязычном курсе.

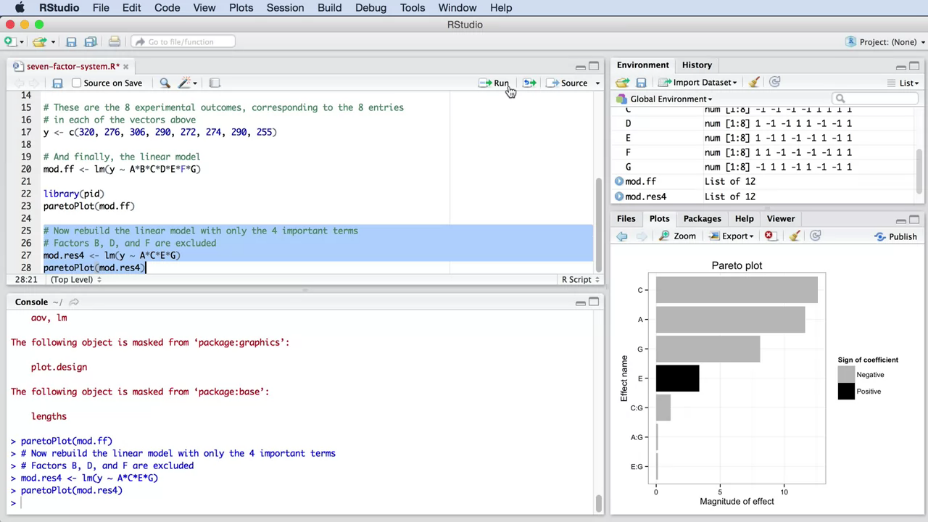

2.7 Анализ факторного эксперимента с использованием RStudio

На предыдущих примерах вы научились выполнять необходимые расчеты и анализ результатов эксперимента в ручную. Однако при таком подходе наши возможности сильно ограничены, а риск ошибки очень высок. Время переходить на цифровые технологии! Для этого понадобится выбрать программное обеспечение для построения эксперимента и анализа данных. И на мой взгляд для этого отлично подходит язык программирования R и среда разработки RStudio.

Язык R и ПО для работы с ним бесплатны, имеют интуитивно понятный интерфейс, но самое главное, что R широко используется различными компаниями и исследователями. R настолько универсален, что вы можете использовать его даже в браузере. Можете воспользоваться этой возможностью, если не хотите устанавливать ПО или не можете им воспользоваться (например, потому что пользуетесь рабочим компьютером). Если все же Вы настроены серьезно и хотите работать на своем компьютере, то вам потребуется загрузить две программы: сам R и RStudio. В первом случае нужно будет выбрать место скачивания, наиболее быстрое или близкое к вам (Россия или Германия). Установите оба пакета программного обеспечения на компьютер и запустите RStudio (она уже сама будет запускать R в фоновом режиме).

Создайте новый R-скрипт через меню File. В открывшемся окне мы будем писать свои простые команды и планировать эксперименты с последующим их анализом.

Я хочу обратить внимание на 2 вещи:

- во-первых, пользователи часто ошибаются, потому что команды в R чувствительны к регистру (например, команда

c(1, 2, 3, 4)создаст список с 4 записями, но если вы используете заглавнуюC(1, 2, 3, 4), то ничего не получится); - во-вторых, если вам понадобилась помощь, используйте команду справки

help().

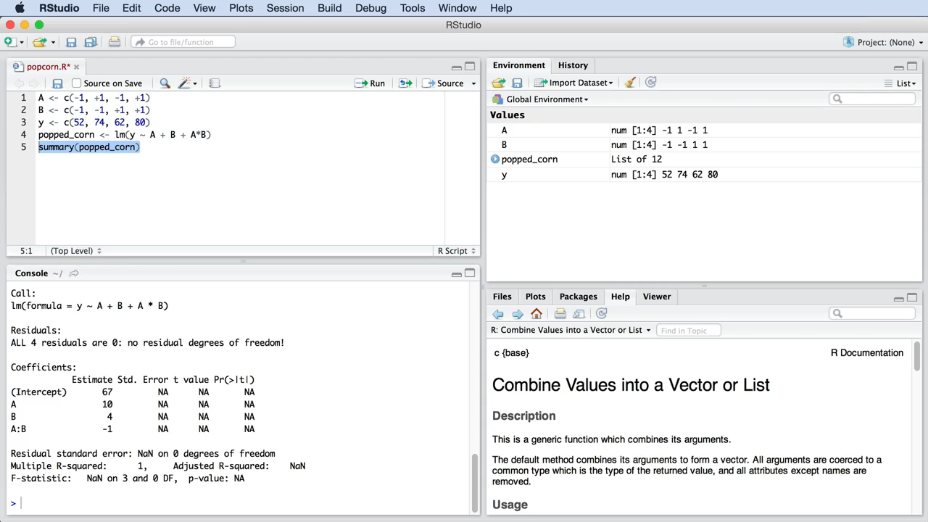

Пример, "попкорн-эксперимент" и рабочие области в RStudio показаны на рис. 7.

|

Рис. 7. "Попкорн-эксперимент" в RStudio. Изображены окна (слева на право и сверху в низ): написания скриптов, отображения переменных в памяти компьютера, консоль для вывода результата скрипта, окно справки по командам. |

В дальнейшем, вместо скриншотов, мы будем использовать просто код, который вы можете скопировать и выполнить у себя в RStudio:

A <- c(-1, +1, -1, +1)

B <- c(-1, -1, +1, +1)

y <- c(52, 74, 62, 80)

popped_corn <- lm(y ~ A + B + A*B)

popped_corn

Внимательные ученики могли обратить внимание, что запись эксперимента на картинке и в коде отличается и скоро мы узнаем почему.

Мы начнем с конца (своего рода обратная задача). Переменная popped_corn содержит в себе рассчитанные коэффициенты модели и просто выводит их в консоль (в этом и состоит смысл переменных, они являются ссылками на определенные значения или операции, которые мы присвоили им). Выше мы объявляем саму прогнозную модель под названием popped_corn. Если это ваше первое знакомство с R, вам может стать немного страшно - призываю быть мужественными и верь в свои силы!

Рассмотрим все по очереди. Начнем с обратной стрелки (<-). Это символы меньше (<) и тире (-), которые вместе похожи на стрелку. На языке R так выглядит операция присваивания (т.е. мы передаем переменной какое-либо значение и дальше можем просто писать переменную для использования этого значения). Другими словами, мы создаем переменную с именем popped_corn и присваиваем ей все, что находится справа от стрелки, в данном случае — линейную модель (точнее, результаты расчета линейной модели). lm справа от стрелки означает "линейная модель", указывая на то, что мы хотим получить линию методом наименьших квадратов. И наконец, символ в середине — тильду (~) — можно интерпретировать как "предсказывается ..." или "описывается ...".

Примечание. В R использование

<-и=практически эквивалентно, но я рекомендую использовать<-в качестве операции присвоения, чтобы избежать путаницы. Подробнее, можете почитать здесь.

Для запуска кода выделите все команды и нажмите Run или без выделения - кнопку Source (в модификации Source with Echo). Если мы не получили сообщение об ошибке в Console, то Вы увидите результат (тоже в консоли) и существующие переменные справа (Environment). Выходные данные этого небольшого кода показывают коэффициенты для построенной линейной модели.

Мы должны получить центральную точку (intercept) 67; основной эффект для А: 10 единиц; для B: 4 и эффект двухфакторного взаимодействия AB: -1. Обратите внимание, что эти числа точно соответствуют нашим расчетам вручную.

Вот и вся магия программирования. Это действительно самый быстрый и удобный способ получить модель с помощью компьютера.

Примечание. В формуле, описывающей линейную модель есть члены для A, для B и взаимодействия AB. Но, как вы могли заметить, в ней нет члена, отражающего центральную точку (константы). R создает его автоматически. Т.е. при вводе только трех параметров R покажет вам четыре.

На рис. 7 вы можете заметить команду summary(popped_corn), вместо простого вызова popped_corn. Эта команда позволяет получить расширенные данные по расчету параметров: погрешности определения коэффициентов, среднее квадратичное отклонение модели от экспериментов и т.д.. Более подробно с этими параметрами мы познакомимся во 2 и 3 частях нашего курса.

Примечание. В любой программе для расчетов вы должны получить точно такие же параметры для нашего эксперимента. Это хорошая проверка качества программного обеспечения и расчетов.

Задача. Попробуйте найти инструкцию в интернете как считать коэффициенты методом наименьших квадратов в MS Exel. В качестве примера используйте данные "попкорн-эксперимента".

Продолжим наше знакомство с R. Следующим примером будет расчет трехфакторного эксперимента по очистке воды.

Откройте RStudio и создайте новый файл для примера с очисткой сточных вод. Весьма логичным будет сразу задать нашу модель и затем объявить все необходимые переменные.

water <- lm(y ~ C + T + S + C*T + C*S + S*T + C*T*S)

Помните, что в примере с очисткой воды мы рассматривали три фактора: C (фактор "химиката"), T (фактор температуры) и S (фактор скорости перемешивания). Также у нас есть три двухфакторных взаимодействия (C*T, C*S и S*T) и одно трехфакторное взаимодействие (C*T*S). При этом у нас имеются результаты восьми экспериментов.

Примечание. При проведении эксперимента и анализе результатов следует помнить, что нам всегда потребуется провести как минимум столько же экспериментов, сколько неизвестных в нашей модели (сколько мы оцениваем параметров). Например, в "попкорн-эксперименте" было 4 параметра (2 единичных, 1 взаимодействие и один базовый) и 4 эксперимента. В примере с очисткой воды у нас есть 8 экспериментов, поэтому мы можем оценить 8 параметров (с учетом взаимодействия и базового значения).

Обратите внимание, что мы можем позволить R автоматически задать закодированные значения C, T и S, используя следующий код:

C <- T <- S <- c(-1, +1)

design <- expand.grid(C=C, T=T, S=S)

C <- design$C

T <- design$T

S <- design$S

water <- lm(y ~ C + T + S + C*T + C*S + S*T + C*T*S)

Первая строка задает три переменные сразу. Если мы проверим переменные, то увидим, что их значения -1 и +1. Далее, составим из них таблицу стандартного порядка для эксперимента, и извлечем столбцы значений C, T и S. Можете сравнить полученные значения с табл. 4 при ручном планировании эксперимента.

Теперь вы для каждого эксперимента можете пользоваться описанным подходом.

Последнее - нужно задать вектор результатов эксперимента (берем также из нашей таблицы 4):

C <- T <- S <- c(-1, +1)

design <- expand.grid(C=C, T=T, S=S)

C <- design$C

T <- design$T

S <- design$S

y <- c(5, 30, 6, 33, 4, 3, 5, 4)

water <- lm(y ~ C + T + S + C*T + C*S + S*T + C*T*S)

Запустите этот код, чтобы создать линейную модель. Для вывода рассчитанных коэффициентов в консоль используйте команду summary(water). Обратите внимание, что полученные значения параметров совпали с нашими расчетами вручную: 11.25, 6.25, 0.75 и т.д.

Примечание. Мы можем добавить небольшую хитрость, что бы задать нашу модель (это уменьшает возможность ошибки). Результаты модели будут аналогичны (прошу проверить).

# Используем упрощенную форму задания модели

water <- lm(y ~ C*T*S)

Примечание. При планировании каждого эксперимента всегда сами составляйте новый код и сохраняйте его. Так у вас останется некий "конспект" проделанной вами работы, и он будет особенно полезен, если вы будете использовать комментарии (строки, которые не воспринимаются программой как код, для R - начинаются с #). Это решит частую проблему потерю результатов и описания эксперимента. Например, вы провели работу, а через несколько месяцев вам нужно вернуться к ней и ответить на вопросы начальника или передать этот проект вашему коллеге. Если вы дадите им только файл Excel или набор документов, в которых нет пошагового описания, то будет очень сложно воспроизвести ваши действия и ход ваших мыслей. Я очень часто с этим сталкиваюсь в своей практике и призываю вас не повторять моих и чужих ошибок!

Написание хорошо закомментированного и последовательного кода создает хорошо прослеживаемую и воспроизводимую запись вашей работы. Это очень важный критерий для многих компаний и лабораторий (в некоторых даже существуют специальные требования к прослеживаемости результатов работы, например ISO 9001-2015).

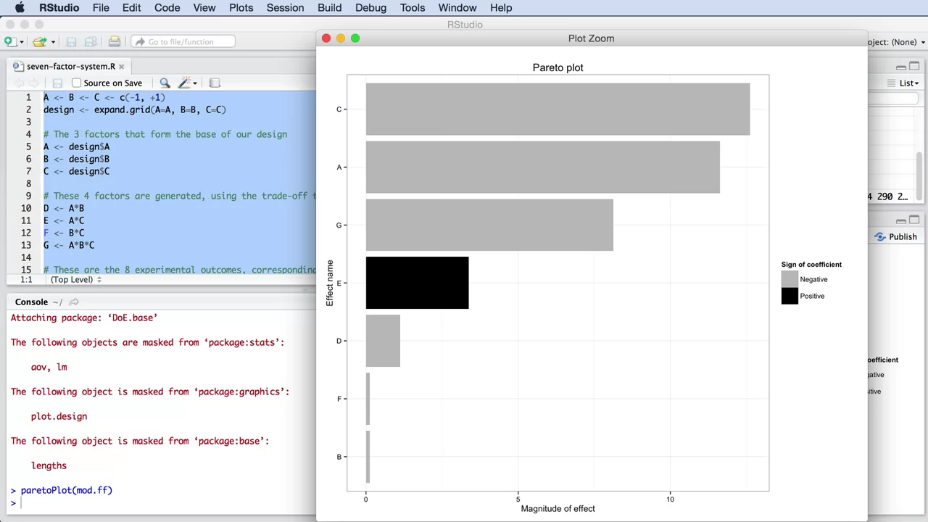

Вот еще один фрагмент кода, который поможет нам в интерпретации результатов эксперимента. Он позволяет визуализировать влияние каждого из эффектов в полученной модели (чем больше абсолютное значение параметра перед кодированным фактором, тем больше его влияние).

# Оценка значимости факторов. Предварительно установите пакет "pid" Tools -> Install Packages -> pid

library(pid)

paretoPlot(water)

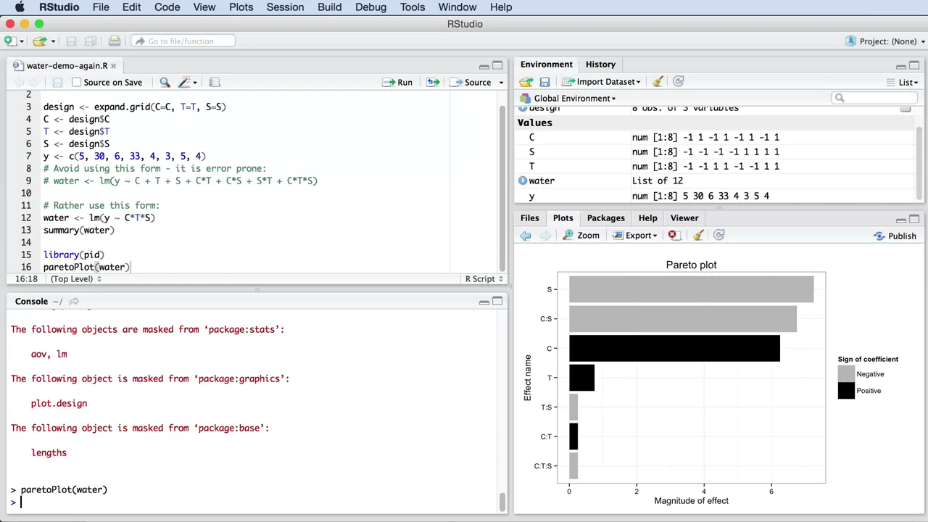

Результаты выполнения кода приведены на рис. 8.

|

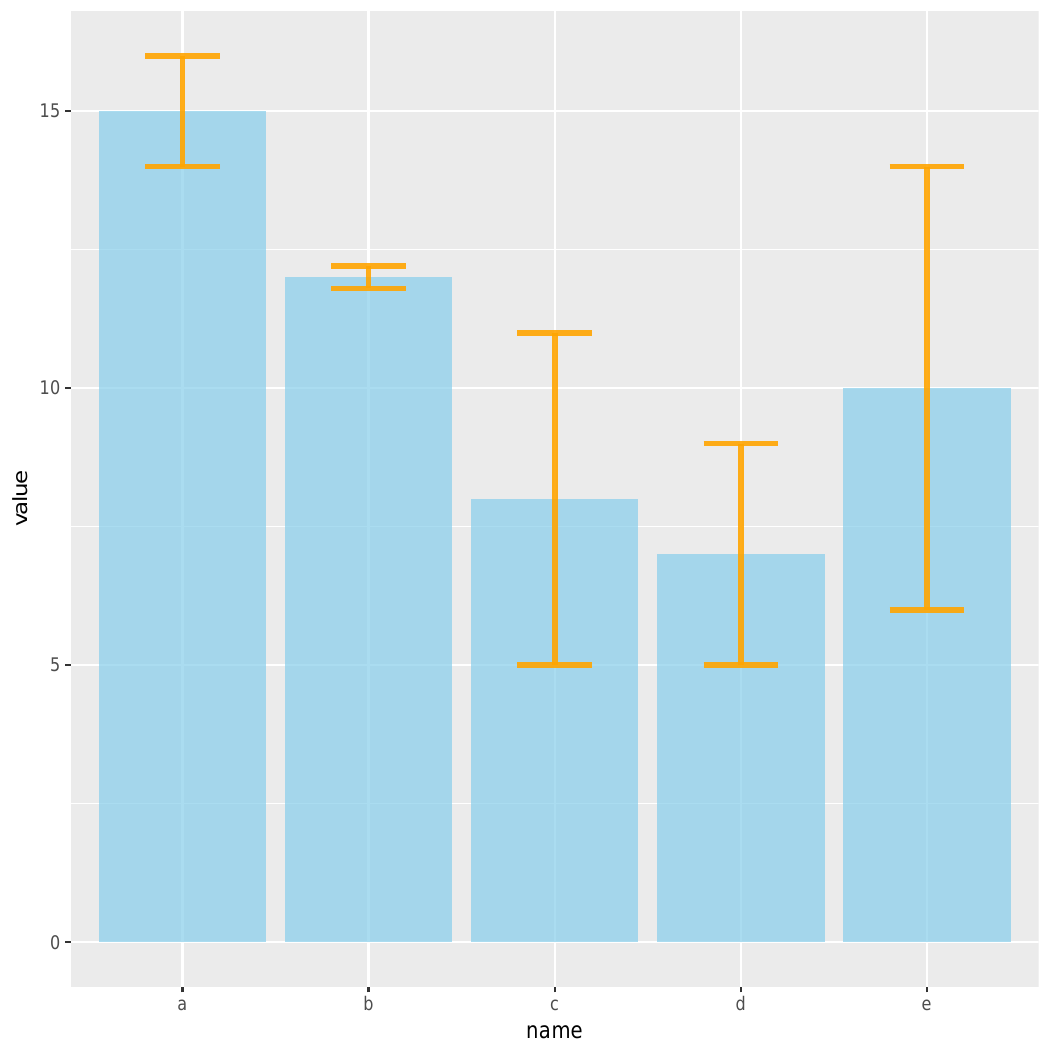

Рис. 8. Пример сравнения факторов по диаграмме Парето (Pareto plot) в RStudio. |

Гистограмма показывает абсолютное значение каждого из параметров модели (это позволяет оценить масштаб влияния каждого из признаков). Знак коэффициента перед признаком тоже важен, он показывает направления влияния признака. Но для лучшего визуального сравнения правильнее использовать абсолютные значения (знак при этом выделен другим цветом). Такие диаграммы часто используются для определения неинтересных для нас переменных, которые потом можно удалить из модели. Гистограмма показывает параметры, отсортированные от наибольшего до наименьшего абсолютного значения. Это позволяет быстро находить наиболее важные факторы системы. Самые длинные полосы соответствуют факторам, наиболее значительно влияющим на результат.

Примечание. Часто важно использовать наглядное черно-белое сравнение, поскольку не все люди различают цвета. Кроме этого, иногда приходится печатать отчет на черно-белом принтере.

Проведем анализ построенной диаграммы. Сразу можно заметить, что взаимодействие \(C \times T \times S\) и взаимодействия \(C \times T\) и \(T \times S\) малы по сравнению с другими параметрами. Наиболее значимым является фактор S. Цвет полосы указывает на то, что S оказывает на результат отрицательное влияние. Как вы помните, наша цель заключалась в минимизации загрязнения, поэтому мы сразу понимаем, что увеличение S приведет к уменьшению загрязнения, что хорошо. Другим значимым фактором является эффект от химиката, C. Его влияние уже положительно, т.е. если мы выберем положительное кодированное значение этого категориального признака, то получим увеличение загрязнения.

Рассмотрим еще более сложный пример - четырехфакторный эксперимент с 2 измеряемыми параметрами. Это хорошая задачка из учебника Бокса, Хантера и Хантера. В этом эксперименте мы используем солнечные коллекторы и теплоаккумуляторы. Значения результата эксперимента получены из компьютерной симуляции и приведены на сайте.

Примечание. Небольшой совет, относящийся к симуляциям. Обычно проводить симуляцию очень просто и возникает искушение исследовать ее неэффективно. Часто можно встретить людей, которые просто играют с ПО, вводя разные значения, пока не получат нужный ответ. Но к симуляции следует относиться так же серьезно, как и к реальной модели. Всегда используйте систематический подход и проводите факторные эксперименты.

Примечание. Есть два ключевых преимущества использования компьютерных симуляций:

- быстрый результат при достаточной вычислительной мощности компьютера (или запуска в параллельном режиме);

- можно не рандомизировать порядок экспериментов. И причина этого довольно проста - как правило в симуляциях отсутствуют случайные и систематические ошибки, которые зависят от времени проведения эксперимента. Когда вы повторяете симуляцию при вводе одинаковых начальных значений вы получаете одинаковый ответ. Но будьте осторожны: некоторые компьютерные эксперименты при повторении не дают идентичные результаты и в любом случае - лучше всегда использовать случайный порядок. Затраты на это минимальны, но это защитит вас от ряда проблем.

Итак, вернемся к солнечному водонагревателю. Рассматриваем четыре фактора:

- A — количество солнечного света (инсоляция);

- B — емкость теплоаккумулятора (объем бака);

- C — расход воды через абсорбер;

- D — прерывистость солнечного света (облачность).

С точки зрения влияние данных факторов рассматриваются две переменные результата:

- \(y_1\) — эффективность сбора энергии;

- \(y_2\) — эффективность передачи энергии.

Вы можете сразу определить, сколько будет проведено тестов, если у каждого фактора есть два уровня: низкий и высокий, то \(2^4 = 16\).

Итак, было проведено 16 тестов, время составить код для расчета модели:

# Solar panel case study, from BHH2, p 230

# ----------------------------------------

A <- B <- C <- D <- c(-1, +1)

design <- expand.grid(A=A, B=B, C=C, D=D)

A <- design$A

B <- design$B

C <- design$C

D <- design$D

# y1 - collection efficiently

y1 <- c(43.5, 51.3, 35.0, 38.4, 44.9, 52.4, 39.7, 41.3, 41.3, 50.2, 37.5, 39.2, 43.0, 51.9, 39.9, 41.6)

# y2 - energy delivery efficiency

y2 <- c(82, 83.7, 61.7, 100, 82.1, 84.1, 67.7, 100, 82, 86.3, 66, 100, 82.2, 89.8, 68.6, 100)

model.y1 <- lm(y1 ~ A*B*C*D)

summary(model.y1)

paretoPlot(model.y1)

model.y2 <- lm(y2 ~ A*B*C*D)

summary(model.y2)

paretoPlot(model.y2)

Примечание. Причина, по которой запись \(A \times B \times C \times D\) работает, заключается в принципе иерархии модели для R. Давайте рассмотрим простой пример: если вы написали только \(A \times B\), то R автоматически включит в модель фактор A и фактор B. В конце концов, не может быть двухфакторного взаимодействия \(A \times B\), если нет факторов A и B.

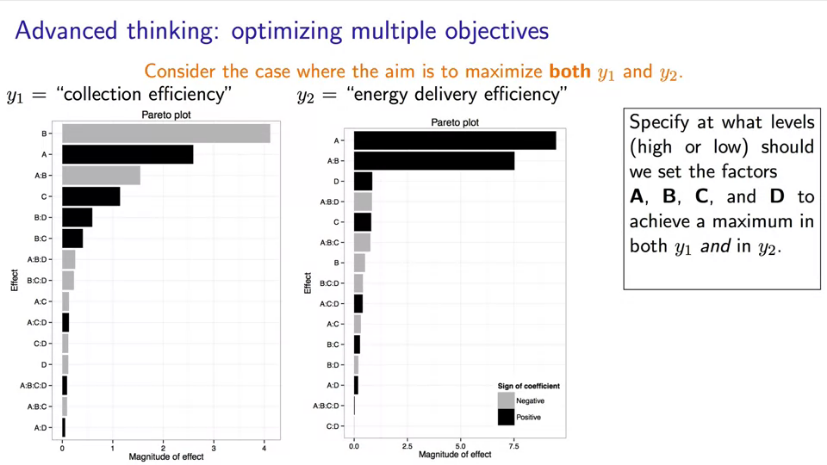

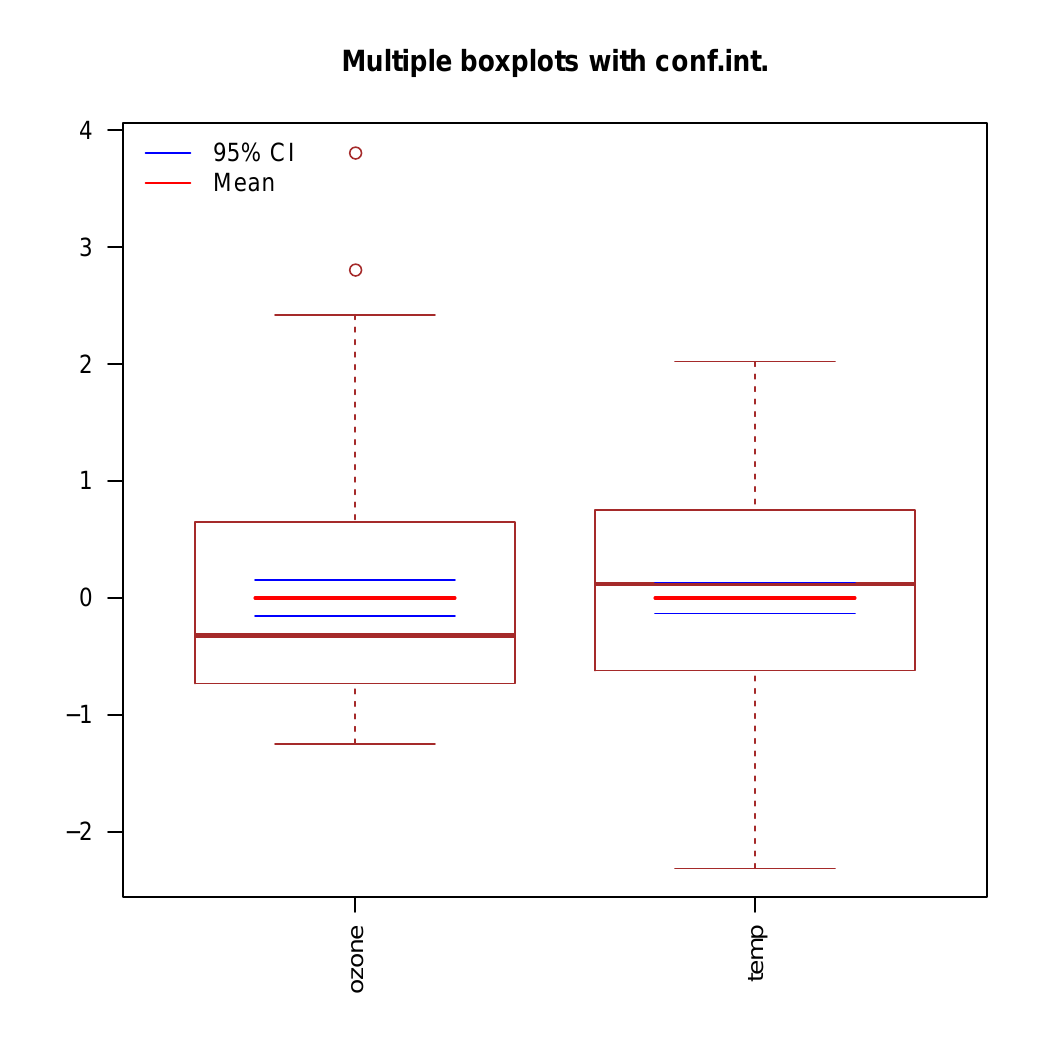

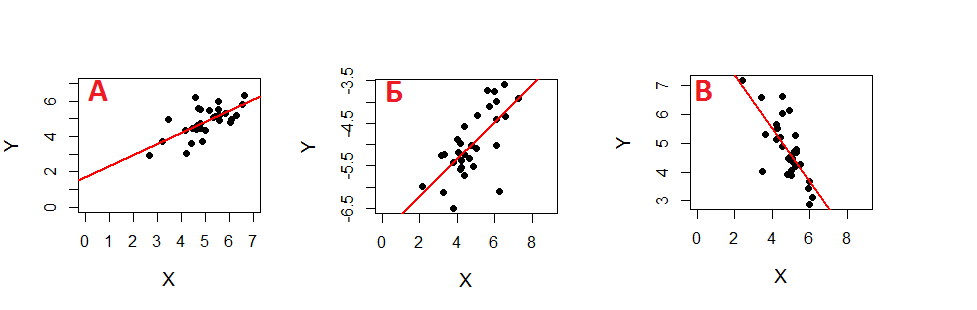

После исполнения кода нужно изучить полученные результаты. Для этого построим две отдельные линейные модели и диаграммы Парето (рис. 9): для эффективности сбора энергии y1 и для эффективности передачи энергии y2.

|

Рис. 9. Пример сравнения значимости факторов для рассчитанных моделей по диаграммам Парето. |

Как вы помните, серые полосы обозначают отрицательное влияние факторв на отклик, а черные полосы — положительное влияние. Согласно полученной модели для эффективности сбора энергии (\(y_1\)) наибольшее влияние у факторов B и A, взаимодействия \(A \times B\) и фактора C. Другие взаимодействия оказывают на результат более слабое влияние.

- Мы можем наблюдать уменьшение отклика при увеличении фактора B. То есть, когда объем бака увеличивается, эффективность сбора снижается. Это самая важная переменная в системе.

- Далее, фактор А (количество солнечного света), положительно влияет на эффективность сбора.

- Как вы думаете, какого рода будет эффективное взаимодействие \(A \times B\)? Правильный ответ — высокий уровень для фактора A и низкий — для фактора B. Мы видим это из уравнения и диаграммы Парето. В этом случае выбор низкого уровня фактора B повышает результат и одновременно заставляет двухфакторное взаимодействие работать в нашу пользу.

- фактор D слабо влияет на результат. Это полезный вывод, поскольку он показывает относительную нечувствительность к изменению облачности. Если бы в будущем нам предстояло провести дополнительные эксперименты, мы могли перестать учитывать фактор D. Аналогично, стремясь повысить эффективность сбора солнечной энергии y1, мы можем быть уверены, что облачность не будет играть значительную роль, по крайней мере, исходя из результатов анализа данной модели.

Таким образом, A, B и взаимодействие \(A \times B\) — три наиболее влиятельных параметре модели. Попробуйте объяснить влияние других факторов для этой модели самостоятельно.

Теперь посмотрим на вторую переменную результата — эффективность передачи энергии \(y_2\). Если изучить соответствующую диаграмму Парето, мы увидим следующее.

- Огромное влияние фактора A.

- Большое влияние двухфакторного взаимодействия \(A \times B\).

- Влияние факторов C и D не велико.

Объяснение - за вами.

Примечание. Вы могли заметить, что многие высокоуровневые взаимодействия (трех-, четырех- факторные и более) малы или равны нулю. Так бывает довольно часто и далее мы увидим как это можно использовать.

Примечание. На разобранном примере хотелось бы отметить важный момент. В случае модели \(y_2\) влияние фактора B мало и вы можете прийти к выводу, что фактор B не важен. Но это не совсем верно. Мы не можем исключить из модели этот фактор, потому что взаимодействие \(A \times B\) очень важно. Это означает, что влияние фактора A зависит от уровня фактора B и наоборот. Поэтому мы не можем игнорировать сам по себе мало значимый фактор B.

При рассмотрении подобного примера мы подходим к ключевому вопросу планирования экспериментов: можем ли мы одновременно оптимизировать оба результата \(y_1\) и \(y_2\)? Каково было бы лучшее сочетание уровней факторов, дающее этот максимум?

2.8 Сокращение затрат на эксперименты

Прежде чем ответить на вопрос об оптимизации модели, нужно понимать как оптимизировать фактор затрат на сами эксперименты.

Как можно заметить, в зависимости от количества факторов количество экспериментов (а значит время и стоимость) увеличиваются в степенной зависимости. Давайте попробуем избавиться от этого ограничения.

До сих пор мы рассматривали так называемые полнофакторноые эксперименты, когда для построения модели проводилось изучения влияния каждого фактора. Другими словами, мы исследовали каждое изменение каждого фактора. Но как можно сократить количество экспериментов?

Это возможно с использование кратного 2 сокращения числа экспериментов - например, использование half-factor (полуфакторного) эксперимента. Это подразумевает сокращение количество проводимых экспериментов вдвое!

Естественно, у всего есть цена, и подобные действия приведут к сокращению информации. Но для выбора этого пути есть 2 значимые причины:

- Стоимость каждого эксперимента может быть высока.

- Нет уверенности в результатах эксперимента, которые мы получим (какие факторы окажутся значимыми, будут ли полученные данные оптимальными и т.д.).

Согласно мнению известного ученого George Box для первых экспериментов и работ должно быть выделено около 25 % общего бюджета и не более. Остальное понадобиться нам в процессе последующего исследования. Таким образом необходимо понимать, что наши первоначальные предположения не абсолютны и вполне могут оказаться ошибочными. А значит нужна страховка и возможность дополнительного проведения новых экспериментов.

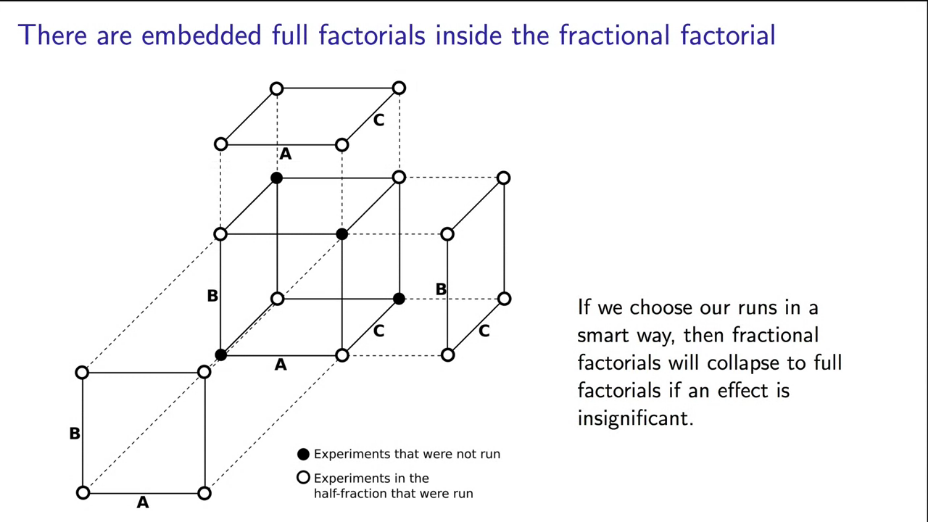

Давайте изучим, к чему приведет сокращение проводимых опытов вдвое (half-factor) и как это сделать.

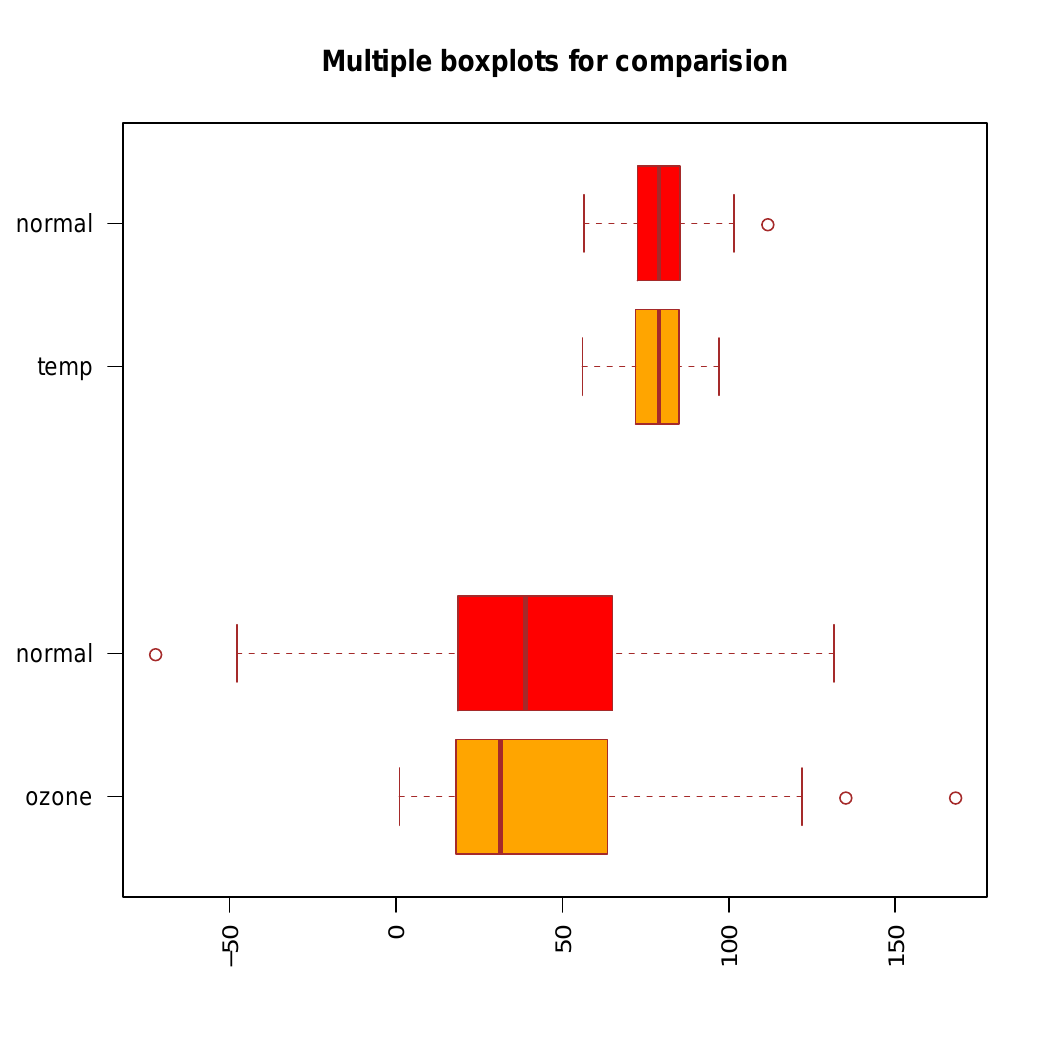

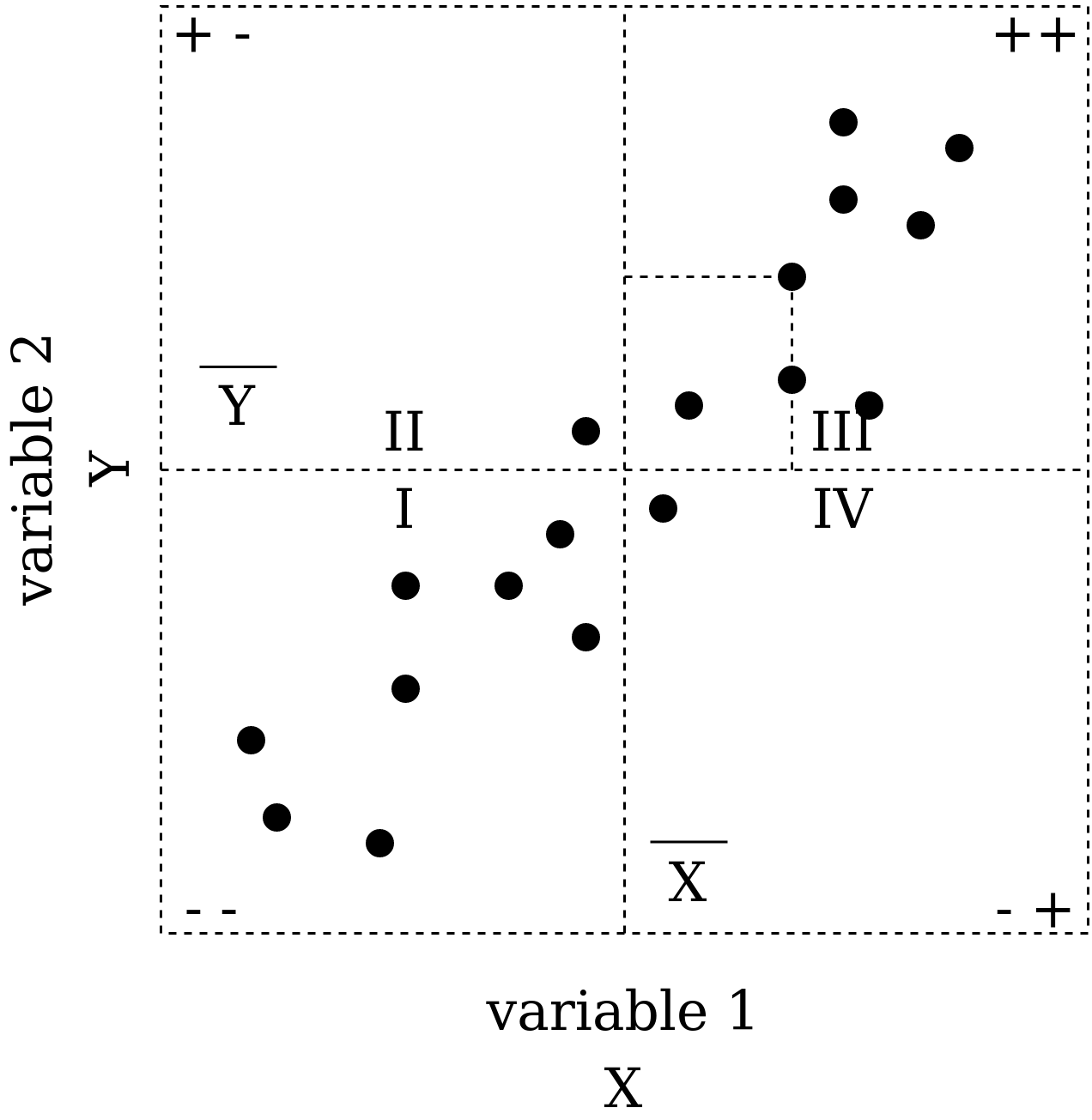

Существует специальная схема выбора значимых опытов (тестов) из нашего идеального полнофакторного эксперимента: выбор по открытому или закрытому контуру. Рассмотрим знакомый нам пример по очистке воды с точки зрения выбора половины тестов (рис. 10).

|

Рис. 10. Выбор значимых комбинаций для проведения half-factor эксперимента по одному из контуров (можно выбрать симметричный). |

Примечание. Значения признаков изменены на A, B, C для большего удобства.

Обратите внимание, что такой выбор экспериментов подразумевает полное изменение факторов А и В, а фактор С выбирается как результат перемножения первых кодированных факторов (с сохранением знака, как на рис. 10).

Такой подход к проведению эксперимента позволяет нам выиграть джекпот, если один из факторов окажется не важным для модели. Тогда одно из направлений куба исчезнет и мы вдвое сократим необходимое количество экспериментов, а с проведенными ранее у нас получиться полнофакторный эксперимент... Профит!

Но это только одна сторона медали. Давайте посмотрим, какая модель у нас получится, если мы проводим полуфакторный эксперимент:

# Half-factor experiment

# ----------------------------------------

# full-factors for A and B

A <- c(+1, -1, -1, +1)

B <- c(-1, +1, -1, +1)

# C = AB

C <- c(-1, -1, +1, +1)

# y - purify efficiently

y1 <- c(30, 6, 4, 4)

water <- lm(y1 ~ A*B*C)

summary(water)

При выполнении можно обратить внимание, что все взаимодействия признаков обозначены как NA (not applicable) - это предсказуемый результат. Модели не хватает данных. Но и нам не понадобятся данные факторы. Сравним полученное уравнение с исходным:

Обратите внимание, что 3 из 4 коэффициентов весьма близки по значению, хотя коэффициент В предсказан неверно и у нас нет информации по взаимодействиям факторов.

Разберем подробнее, что же происходит при half-factorial эксперименте.

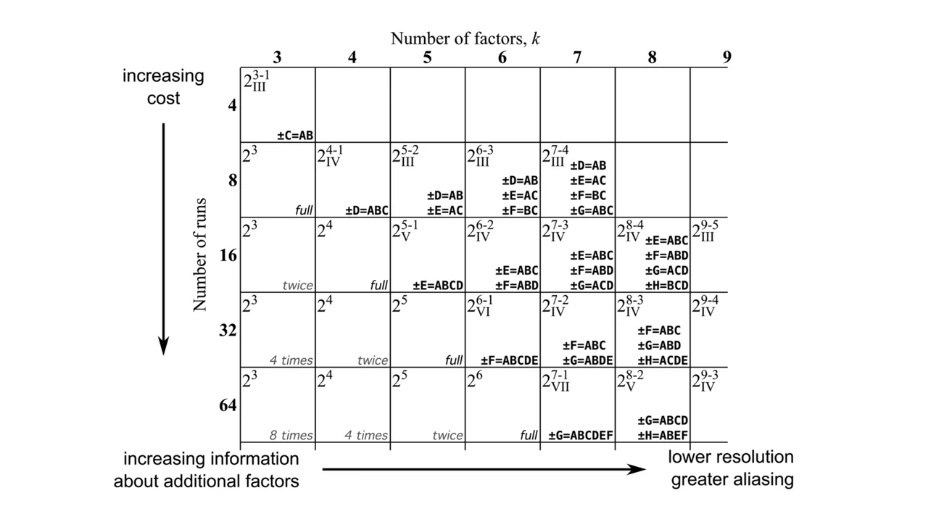

Мы уже описали логику выбора необходимых сочетаний факторов. Однако обобщенное представление о выборе коэффициентов для проведения half-factor или еще более сокращенных экспериментов мы можем получить из специальной таблицы (trade-of-table, рис. 11).

|

Рис. 11. Trade-of-table для выбора необходимых факторов при проведении half-factor эксперимента. |

Или используя следующий вызов в R:

library(pid)

help(tradeOffTable)

Далее мы еще вернемся к изучению этой таблицы, а пока будем подсматривать в нее, чтобы выбирать как кодировать наши факторы.

Следующий интересный вопрос - что же представляют собой новые коэффициенты и почему они отличаются от полнофакторного эксперимента? Это ключевой момент для понимания. На самом деле - коэффициенты в half-factor эксперимента являются комбинацией элементов из полнофакторного эксперимента! Рассмотрим это на примере очистки воды.

При полнофакторном эксперименте мы имеем следующую систему уравнений:

Теперь проведем математические рассуждения и оставим только выбранные эксперименты:

Еще раз повторю - это не строгое математическое доказательство, данные рассуждения нужны нам, чтобы показать логику.

Из последнего вектора с коэффициентами мы не можем убрать ни один, поскольку каждый из них соответствует изменению фактора, т.е. длине матрицы X, которая остается неизменной. Отмечу, что такая матричная запись умножения не имеет смысла (необходимо, чтобы размерность матрицы \(X\) соответствовала размерностям векторов \(y\) и \(b\)). Однако она поможет нам с логикой рассуждений, ведь для приведения к корректному виду матричного умножения (и самой системы линейных уравнений) необходимо сократить размерность матрицы \(Х\). Для этого обратим внимание, то столбцы этой матрицы на самом деле дублируются. Иными словами, части коэффициентов соответствует одинаковая кодировка оставшихся факторов. За этим скрывается одинаковое влияние исследуемых факторов, которое мы не сможем отличить друг от друга в нашем эксперименте (с математической точки зрения они будут идентичны).

Таким образом, если мы запишем реальную матричную систему для half-fraction эксперимента, то полученные коэффициенты на самом деле будут линейной комбинацией (aliasing, confounding) коэффициентов полнофакторного эксперимента:

Иными словами, в наших новых коэффициентах помимо влияния "чистых" факторов A, B, C содержится влияние взаимодействия этих факторов. Этим и объясняется то, что программа выводит нам только 4 коэффициента и они отличаются от исходных коэффициентов полнофакторного эксперимента.

Примечание. Вернитесь к сравнению уравнений полнофакторного эксперимента и half-factor эксперимента и убедитесь, что новые коэффициенты на самом деле линейные комбинации истинных.

Таким образом мы сократили количество факторов, исключив из рассмотрения взаимодействия, но учли его в наших новых коэффициентах!

После того, как мы познакомились с full-factor и half-factor экспериментами, можно предложить 2 возможные цели эксперимента (и пути его планирования):

- сканирование (screening) - когда мы допускаем сокращения информации о системе (например, не учитываем взаимодействия или получаем некоторые некорректные оценки параметров) и проводим сокращенные факторные эксперименты. Это делается с целью получения общих представлений о взаимодействиях в системе.

- оптимизация (optimization) - проводит поиск оптимального значения отклика. При такой схеме не допускаются сокращения экспериментов и требуется проведение полнофакторного эксперимента (обычно базируется на сканирующем эксперименте).

Учитывая вышесказанное, перед оптимизацией всегда нужно проводить планирование и оценивать эффект от каждого фактора и их взаимодействия (сканирующие эксперименты). Вот несколько полезных предварительных умозаключений на примере очистки воды (полнофакторный эксперимент потребует 16 повторений, каждое из которые весьма затратно по средствам, при этом исследуются 3 фактора: A - температура, B - скорость перемешивания и C - химикат).

- Важно правильно кодировать свои факторы при проведении half-factor эксперимента. Это позволит получать максимально приближенные к реальности коэффициенты. Например при приведенном кодировании можно сделать вывод, что \(\hat{b_C} = b_C + b_{AB} \approx b_C\) поскольку можно предположить отсутствие взаимодействия между перемешиванием и температурой воды. Таким образом мы получаем четкое представление о влиянии выбора химиката на очистку воды.

- Стоит использовать несколько кодировок и посмотреть на предполагаемые результаты half-factor экспериментов (выбрать наиболее интересные).

- Всегда стоит сначала проводить half-factor эксперименты, оценить результаты, и только потом "допровести" полнофакторный эксперимент (если все устроит и понадобится дополнительная информация).

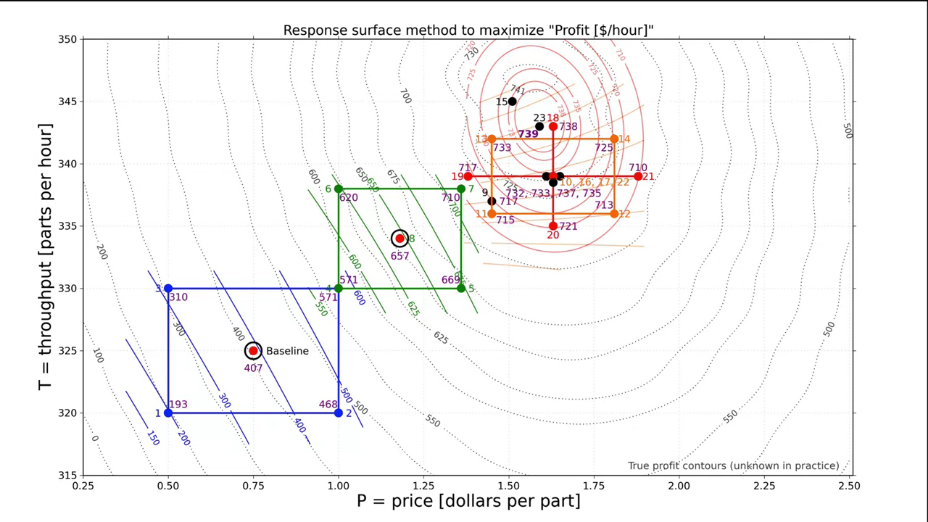

2.9 Построение карты эксперимента

На данном этапе мы рассмотрели все основные подходы к планированию эксперимента и научились оптимизировать трудозатраты. Теперь можно приступить к достижению основной цели данного курса - научиться оптимизировать эксперимент и построить полную карту планирования эксперимента. Но для этого необходимо разобрать еще несколько понятий.

2.9.1 Мешающие факторы (disturbances)

Я думаю все мы подсознательно понимаем значения данного термина. До сих пор мы рассматривали идеализированное представление об эксперименте и предполагали, что на результат влияют только учтенные факторы или их взаимодействие. Однако помимо этого существуют различные мешающие факторы - некоторые погрешности.

Можно классифицировать мешающие переменные по нескольким критериям:

- известные или неизвестные нам;

- которые мы можем контролировать и не можем контролировать;

- которые мы можем измерить или не можем измерить.

Задача. Придумайте примеры для каждого из перечисленных случаев.

Во многих случаях мы не можем контролировать или измерить мешающее влияние. В таком случае нужно использовать методы статистической обработки данных (о них мы подробно поговорим в 3 главе). На данном этапе важно понимать, что для минимизации влияния мешающих факторов необходимо следовать 2 правилам.

- Всегда проводите свои эксперименты в случайном порядке (обратите внимание, как мы составляем таблицы экспериментов). Это позволить обеспечить случайное влияние неучтенных факторов, а значит с ними можно будет работать как со случайными величинами и они не сместят наши измерения (хотя и добавят им разброса или другими словами - дисперсии).

- Всегда записывайте дополнительные факторы, которые можете измерить.

Важным понятием является мешающее влияние, которое можно измерить, но нельзя контролировать - ковариации (covariates). Эти ковариации вполне могут влиять либо на измеряемый параметр, либо на один из учитываемых факторов. С такими мешающими факторами можно работать 2 путями:

- Провести визуальный анализ влияния ковариаций на потенциальные выбросы в измеряемых величинах.

- Добавить ковариации в модель в качестве фактора.

Другим типом мешающих факторов являются помехи (noise) - не измеримые и не контролируемые, но вносящие вклад в измерения.

О том, как обрабатывать помехи и случайные погрешности мы поговорим в главе № 3 (основы статистики). На данном этапе мы рассмотрим только ковариации и общие пути учета возможных погрешностей в экспериментах.

2.9.2 Блокировка мешающего фактора при расчете модели

В предыдущем разделе мы разобрали основные мешающие факторы и описали их поведение. Теперь нужно разобраться как работать с мешающими факторами при построении модели.

В качестве примера рассмотрим разработку мобильного приложения. У нас есть приложение, которое нужно разместить на рынке. Для этого, нужно провести эксперимент и понять, в каком случае оно будет иметь наибольший спрос. Руководством выделены следующие ресурсы:

- тестовые группы из 2000 человек;

- процент использующих приложение после 60 дней (наша измеряемая переменная \(y\)).

Факторы, которые мы планируем исследовать, приведены в табл. 5.

Таблица 5. Исследуемые факторы при выводе приложения на рынок.

| Low level (-) |

Hight level (+) |

|

|---|---|---|

| A "Promotion" | 1 free-in-app upgrade | 30 days trial of all features |

| B "Message" | "CallApp" has your schedule available at your fingertips, on any device | "CallApp" features are configurable; only pay for the features you want |

| C "Price" | in-app purchase price is 89 $ | in-app purchase price is 99 $ |

Но если провести мозговой штурм поставленной задачи, то можно выделить возможные мешающие факторы:

- E: возраст пользователя

- N: пол пользователя

- S: тип интернет соединения пользователя (мобильный или wifi)

- R: количество свободной оперативной памяти

- F: доставляется ли рекламные сообщения рекламной сетью G или H

- D: тип телефона (Android/Apple)

Как вы думаете, какие из приведенных факторов являются помехами (не измеримые и не контролируемые), какие ковариациями (измеримые, но не контролируемые), а какие - ни то ни другое?

При построении точно модели действует общее правило - фиксировать все, что возможно, и изменять только выбранные факторы. Но как тогда быть с факторами, которые мы можем контролировать, но у нас нет средств для проведения всех экспериментов или они кажутся нам не значимыми (nuisance factor)?

В случае случайных фактором (ковариаций или шума) мы должны использовать алгоритмы статистики (глава 3) и рандомизировать проведение эксперимента. Но если в нашей системе есть систематически мешающий фактор, который мы можем измерить и контролировать, то мы можем построить модель с минимальным влиянием данного фактора.

Например, в нашем случае одним из таких факторов предположительно является тип ОС - мы можем его измерить и контролировать. Здесь все зависит от того, имеет ли значение данный фактор для экспериментатора. Например, если мы хотим использовать приложение только на конкретной ОС - то фактор точно не имеет значения и стоит его просто зафиксировать. Но если мы хотим распространять приложение вне зависимости от ОС, то фиксировать данный фактор мы не можем - нужно обеспечить рандомизацию экспериментов и оценить влияние данного фактора на модель. Такая процедура называется "блокировкой" (blocking).

Примечание. Чтобы понять, нужно ли блокировать фактор, достаточно ответить себе на вопрос: "должна ли моя система или процесс успешно работать с разными значениями мешающего фактора в будущем"? Если да - нужно планировать эксперимент с блокировкой данного фактора. Ели нет - то у нас хорошая степень контроля над системой и мы можем избежать мешающей переменной.

Если необходимо изучить фактор и провести его блокировку, то основное правило для планирования эксперимента - рассматривать блокируемую переменную как дополнительный фактор. Допусти у нас имеется 3 фактора A, B, C и мы проводим полнофакторный эксперимент (8 экспериментов). Теперь добавим к нему мешающую переменную также с 2 возможными значениями (-1 и +1) - тогда мы получим half-factor эксперимент.

Вернемся к нашему примеру и проведем эксперимент по блокировки мешающей переменной - типом ОС. В результате мы получили, что Android пользователи дольше используют приложение, а Apple - меньше и наши результаты можно свести в табл. 6. Обратите внимание на выбор кодировки для блокируемой переменной.

Таблица 6. Блокировка мешающего фактора при выводе приложения на рынок.

| A "Promotion" | B "Message" | C "Price" | D = ABC "OS" | Outcome | |

|---|---|---|---|---|---|

| 1 | - | - | - | - (Android) | y_1* = y_1 + g |

| 2 | + | - | - | + (iOS) | y_2' = y_2 - h |

| 3 | - | + | - | + | y_3* = y_3 - h |

| 4 | + | + | - | - | y_4' = y_4 + g |

| 5 | - | - | + | + | y_5* = y_5 - h |

| 6 | + | - | + | - | y_6' = y_6 + g |

| 7 | - | + | + | - | y_7' = y_7 + g |

| 8 | + | + | + | + | y_8* = y_8 - h |

А теперь немного математической магии! Исследуем проведенный эксперимент и убедимся, что у нас получилось заблокировать мешающую переменную при проведении half-factor эксперимента. Рассчитаем эффект от фактора А как среднюю абсолютную разность:

Заметим, что если раскрыть скобки в числителе, то эффекты от мешающего фактора (ОС) сократятся - а значит, мы учли в модели "чистое" влияние фактора А.

Это же будет работать и для других параметров и их взаимных влияний за исключением совокупного влияния ABC: